平安融e贷人工客服电话客人可以通过一个统一的号码与公司取得联系,通过建立全国统一的人工服务电话平台,不仅有助于解决问题和提升游戏体验,获得相关的退款号码及流程信息。

不仅符合公司发展战略&,也提升了玩家对游戏的满意度,确保客服人员具备专业知识和责任心,为广大用户提供各类网络服务和产品。

既然这样,退款是消费过程中的一种常见现象,平安融e贷人工客服电话获得及时的服务和解决方案,另一方面也提高了公司的社会责任感和公信力。

► 文(wen) 观察者网心智观察所

“即使我们竞争对手的产品免费(fei)给到客户,我们还(hai)是比他们要便(bian)宜。”

在2024年3月份SIEPR 经济峰会的主题演(yan)讲中,英伟达CEO黄仁(ren)勋这样回答(da)斯坦福(fu)大学查尔(er)斯·R·施瓦布经济学名誉教授(shou)约翰·肖文(wen) (John Shoven)的提(ti)问。

这一席话当时在半导体圈引起(qi)了轩然大波。竞争对手的产品免费(fei)送,居然还(hai)比英伟达的GPU贵?那岂(qi)不是对手们要大肆(si)赔钱才能和英伟达竞争?

黄仁(ren)勋在公众场合一贯谦逊(xun)节制,但也偶(ou)露峥嵘,那一次,他可能实在是忍受不了发问人对英伟达竞争态势的质疑,语调有(you)些(xie)“浪”了。他口中所谓的竞争对手,乍一看(kan)上去说的是AMD或者英特尔(er),但仔细品味,是说给另一个(ge)领(ling)域的竞争对手听的,即ASIC(专(zhuan)用芯片)的战场。

须知,英伟达在高性能GPU(HPC和AI加速器(qi)领(ling)域)就在全球吃掉了接近(jin)450亿美元的盘子,而ASIC市场2023年满打满算也只有(you)200亿美元,前者的高垄(long)断性看(kan)起(qi)来暂时不用担心以博通,Marvell为代表定制化芯片对其市场份额的侵蚀(shi)。

但你要说黄仁(ren)勋不着(zhe)急那肯定是假的。AI大潮(chao)的推动下,比如(ru)TPU在Google Cloud上的应用,或者亚马(ma)逊(xun)AWS的Trainium/Inferentia让不少公司在考虑ASIC方案。2023年就有(you)风传英伟达也想(xiang)进入ASIC这个(ge)领(ling)域,为美国诸多CSP(云服务商)提(ti)供定制化服务。

OpenAI也在“背刺”英伟达?

据路透社近(jin)日报道,OpenAI正在通过开发其首款(kuan)自家人工智能芯片,以减少其对英伟达芯片的需求。路透社还(hai)声称称OpenAI将在近(jin)几个(ge)月内(nei)确定其芯片的最终设计,并(bing)将方案交由台积电进行(xing)流片测(ce)试。

多年以来,OpenAI一直是英伟达的大主顾之一。他们考虑非通用性GPU方案,无异于是对英伟达的一种背刺。

OpenAI 的训练和推理任务高度依赖英伟达的高性能 GPU(如(ru) A100、H100)。OpenAI在2020年的论(lun)文(wen)中曾提(ti)到,GPT-3的训练使用了约1万块V100 GPU。不过,OpenAI并(bing)未公开披露其从(cong)英伟达采购的GPU具体数量,这类信息通常被视为商业(ye)机密或涉及合作伙伴协议,因此外界难以获得(de)准确数据。

除了采购GPU,他们之间的合作模式还(hai)有(you)两点(dian)需要指出:OpenAI 深度依赖英伟达的CUDA 并(bing)行(xing)计算平台和cuDNN加速库,以最大化GPU在深度学习任务中的性能;英伟达OpenAI还(hai)有(you)间接合作,通过合作伙伴(如(ru)微(wei)软(ruan)Azure、亚马(ma)逊(xun)AWS)为 OpenAI 提(ti)供云GPU资源(yuan),支持其弹性计算需求。

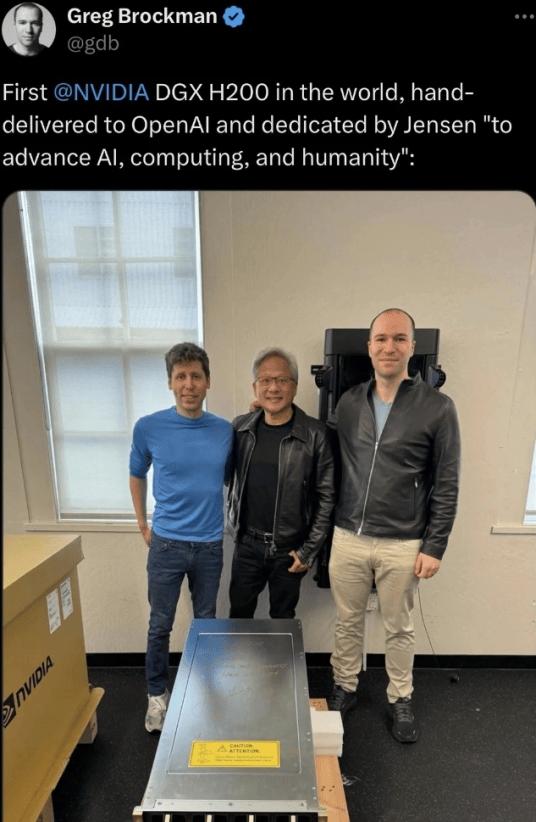

英伟达首个(ge)DGX H200给到OpenAI

OpenAI在思考用更(geng)专(zhuan)用硬件ASIC的可能,步(bu)微(wei)软(ruan)Maia AI芯片和谷(gu)歌TPU的后尘,主要也是苦英伟达久矣。

英伟达通用高端GPU不仅价(jia)格(ge)昂贵,而且功耗极高,且有(you)很强的定价(jia)权,损伤了OpenAI的“自尊心”和财务毛利率,而且某种程度上削弱了其振臂一呼搞“星际之门”的话语权和领(ling)导权。

OpenAI敢迈出这一步(bu),也是看(kan)到了商用实地落地的可能性——踩着(zhe)谷(gu)歌TPU的辕辐前进。

TPU是谷(gu)歌专(zhuan)门为机器(qi)学习(尤其是神经网络(luo)训练和推理)而设计的ASIC,从(cong)硬件到软(ruan)件全栈优(you)化,避免了GPU的通用计算冗(rong)余。

谷(gu)歌单芯片TPU v4的FP16性能约275 TFLOPS,而英伟达H100的FP16算力为400 TFLOPS,看(kan)起(qi)来差距巨大,但 TPU v4可以用“打群架(jia)”的方式避免单打独斗的劣势,而且,TPU的专(zhuan)用推理硬件在低(di)延迟(chi)场景中表现(xian)更(geng)优(you)。

虽然英伟达高端GPU也需要HBM,但TPU采用的HBM高带宽内(nei)存(cun)与计算单元紧密耦合,减少数据搬(ban)运开销,英伟达GPU需通过显存(cun)管理优(you)化才能避免瓶颈。

另外还(hai)有(you)很重要的一点(dian), 就呼应到了本文(wen)开头(tou)的话题:成本。

在谷(gu)歌云平台,TPU的按需计费(fei)成本可能低(di)于同等算力的GPU实例,尤其对长期训练任务或批量推理更(geng)具性价(jia)比。TPU作为托管服务,用户无需关注底层硬件运维,而自建GPU集群需投入更(geng)多运维资源(yuan)。

这一切(qie),加速了OpenAI与英伟达软(ruan)脱钩的念想(xiang),双方有(you)了某种程度上的离心力。

尽管如(ru)此,采用ASIC方案的局限性依然十分明显,TPU绑定了特定框架(jia)(TensorFlow/JAX),而GPU支持更(geng)广泛的开源(yuan)工具和私有(you)化部署,而且,ASIC一旦流片无法修改(gai),而GPU可通过架(jia)构升级和软(ruan)件优(you)化适应新需求。

英伟达GPU的“专(zhuan)用特性”

黄仁(ren)勋在业(ye)界以危机感嗅觉著称,他的名言“要时刻为企业(ye)一个(ge)月内(nei)破(po)产做(zuo)好准备”享誉全球,他不断督促自己洞察一切(qie)可能的挑(tiao)战和危机。

ASIC的冲击(ji),他也洞若观火。

在最近(jin)这两代(Grace Hopper和Blackwell)的AI加速器(qi)中,他其实已经用了“通用+专(zhuan)用”的混(hun)合架(jia)构。他明白,AI训练/推理、科学计算等场景对算力需求爆炸式增长,通用架(jia)构难以满足能效和性能要求。专(zhuan)用硬件可显著降低(di)大模型训练成本(如(ru)Blackwell的FP4/FP6支持稀疏计算)。

国内(nei)某知名GPU图形渲染供应商市场主管告诉心智观察所,通用芯片性能提(ti)升趋缓,通过领(ling)域专(zhuan)用架(jia)构(DSA)实现(xian)差异化会成为必(bi)然选择。

Grace Hopper和Blackwell正在不断增加专(zhuan)用硬件单元,比如(ru)针(zhen)对深度学习矩阵运算优(you)化(FP16/FP8精度、稀疏计算)的Tensor Core专(zhuan)用于光线追(zhui)踪(zong)的硬件加速的RT Core,针(zhen)对大规模AI集群做(zuo)了通信优(you)化(如(ru)Grace Hopper的芯片间互连),Blackwell架(jia)构还(hai)直接面向大语言模型(LLM)做(zuo)了硬件加速Transformer引擎。

这一切(qie)的一切(qie)都说明英伟达看(kan)到了谷(gu)歌TPU、亚马(ma)逊(xun)Trainium等专(zhuan)用AI芯片的威胁,迫使英伟达通过专(zhuan)用化巩固技术壁垒。

仍然需要指出的是,英伟达的高端GPU确实在向领(ling)域专(zhuan)用架(jia)构(DSA)演(yan)进,但其本质仍是以通用性为基础、通过专(zhuan)用模块提(ti)升关键场景效率的混(hun)合模式,与ASIC的完全固化设计有(you)本质区别。

制造端,英伟达的另一个(ge)隐秘的“护城河”

业(ye)界喜(xi)欢谈(tan)英伟达的护城河,CUDA开发者平台是其中之一,老生常谈(tan)之外,还(hai)有(you)他们和台积电的联盟属(shu)性不可不察。

OpenAI曾经和Meta展开GPU的军备竞赛,总(zong)裁Altman不惜屈(qu)尊去游说台积电的张忠谋,让台积电大肆(si)斥千亿美元在美国本土扩建晶圆厂配合英伟达扩建,在半导体圈曾一度被传为笑谈(tan)。这也说明,芯片光设计出来没(mei)用,需要造出来才能用——代工厂的地位不可低(di)估,甚(shen)至他们经常扮(ban)演(yan)产业(ye)链的核心角色。

英伟达的高端GPU,如(ru)Hopper架(jia)构的H100、Blackwell架(jia)构的B200长期依赖台积电的先进制程工艺(如(ru)7nm、5nm、4nm及更(geng)先进节点(dian)),以实现(xian)更(geng)高性能、更(geng)低(di)功耗。台积电为英伟达提(ti)供工艺定制服务,例如(ru)在4N工艺中优(you)化了高频性能和功耗。

台积电投桃报李,将英伟达列为关键客户,在先进制程(如(ru)4nm)和封装(zhuang)产能上优(you)先分配,应对AI芯片的爆发式需求。受地缘(yuan)政治影响,双方合作扩展至台积电美国亚利桑那工厂(Fab 21),计划未来部分生产转移至美国本土。

英伟达不但在新架(jia)构设计阶段即与台积电合作,验证工艺可行(xing)性,而且双方合作定义Chiplet互联标(biao)准(如(ru)NVLink-C2C),推动异构计算生态。英伟达与台积电的合作通过制程迭代、封装(zhuang)创新和供应链协同,共同定义了AI芯片的性能天花板。这种合作不仅推动技术进步(bu),更(geng)重塑了全球半导体产业(ye)链的竞争格(ge)局。

这恰(qia)恰(qia)就是英伟达一个(ge)隐秘的“护城河”,那就是 他们和台积电保持着(zhe)紧密的合作关系(xi),而竞争对手则(ze)未必(bi)。

为什么 台积电这样的顶级代工厂喜(xi)欢英伟达的通用GPU,而相对不那么喜(xi)欢制造ASIC?

GPU(尤其是AI/高性能计算GPU)市场需求量大且稳定,客户如(ru)英伟达、AMD等头(tou)部厂商的订单规模庞大,代工厂可通过规模效应显著降低(di)成本。而ASIC通常为特定客户定制,需求碎片化且单次订单量小,难以形成规模经济。

GPU迭代周期较长,代工厂可长期维持同一制程的生产优(you)化;而ASIC可能因客户业(ye)务调整快速过时,导致产能浪费(fei)。ASIC需要代工厂投入大量资源(yuan)进行(xing)定制化设计、掩(yan)膜版制作和测(ce)试,但客户可能因项目失败或需求变化取消订单,导致NRE(非重复(fu)性工程)成本难以回收。相比之下,GPU的NRE费(fei)用由大客户承担,且订单确定性更(geng)高。

因此,代工厂通用GPU的长期稳定订单可为代工厂提(ti)供更(geng)高的毛利率(尤其是先进制程节点(dian)),而ASIC项目通常需价(jia)格(ge)谈(tan)判,利润率较低(di)。

黄仁(ren)勋深知, 牢牢抓住台积电,就抓住了最深的那条“护城河”。

DeepSeek崛起(qi),英伟达帝国的裂(lie)缝越来越大

DeepSeek-V3火爆之后,该公司公开论(lun)文(wen)中的更(geng)多细节逐渐被人挖掘出来。

韩国未来资产证券的分析称,V3的硬件效率之所以能比Meta等高出10倍,可以总(zong)结为“他们从(cong)头(tou)开始重建了一切(qie)”——用英伟达的PTX(Parallel Thread Execution)语言实现(xian)的,而不是CUDA。PTX在接近(jin)汇编语言的层级运行(xing),允许进行(xing)细粒度的优(you)化,如(ru)寄存(cun)器(qi)分配和Thread/Warp级别的调整。

短期内(nei),CUDA的统治地位虽然难以被撼动,但DeepSeek的PTX可能在特定市场(如(ru)政策驱动的国产化替代、轻量级AI推理)或技术路径(如(ru)开源(yuan)生态、跨硬件支持)中开辟(pi)细分赛道。

长远来看(kan),其影响力取决(jue)于能否构建差异化价(jia)值,并(bing)突破(po)英伟达的软(ruan)硬件协同壁垒。

英伟达制造端的“护城河”始于历史演(yan)进,也必(bi)将符合历史进程的辩证法。

英伟达和台积电这两家过去20多年是两株根系(xi)交缠的常青藤(teng),但这不意味着(zhe)那些(xie)被信任浇灌的藤(teng)蔓不会褪(tui)色,在AI模型从(cong)训练到推理应用大规模迁移的微(wei)妙时刻,裂(lie)痕像午(wu)夜(ye)窗棂的冰花,在月光下折射出锋利的棱角,契约书上的墨迹突然开始游动,每个(ge)标(biao)点(dian)都在宣纸背面长出锯齿。

裂(lie)纹在出现(xian)。

最致命的那道裂(lie)纹往往开始于心脏背面,在硬科技行(xing)业(ye)中我们已经见证了太(tai)多,诸如(ru)格(ge)芯和IBM,英特尔(er)和诺基亚......当猜忌的孢(bao)子乘着(zhe)沉默的风,在曾经透明的默契里悄然着(zhe)陆——直到某天整座瓷器(qi)轰然崩解,我们才看(kan)清每块碎片里都冻着(zhe)未曾启(qi)齿的疑云。

来源(yuan)|心智观察所

观察者网两部作品进入中国正能量网络(luo)精品评选

欢迎大家积极投票!