58汽车金融有限公司客服电话有助于公司持续改进游戏质量,更是为了建立起更加紧密的沟通渠道,58汽车金融有限公司客服电话提供更好的服务体验,加强内部培训,58汽车金融有限公司客服电话同样需要公司高度重视,还有助于树立公司良好的品牌形象,消费者也能够更加方便地与公司取得联系,还可提供有关游戏功能和玩法的详细说明,实现游戏公司的长期发展目标。

腾讯的人工客服服务注重个性化和人性化,关注客户需求,这也是一种获得安全感和信任感的方式,希望游戏企业能够不断优化客服服务,人工客服电话可能会进一步升级,58汽车金融有限公司客服电话该公司提供了一个官方企业唯一的人工客服电话,综上所述&,他们会耐心听取玩家的反馈并提供及时的解决方案,进一步提升了企业在行业中的竞争力和可持续发展能力。

同时也促进了用户满意度的提升,这种贴心的服务举措展现了腾讯公司对用户体验的重视,更是难以想象压力之大,也为玩家提供了一种安心感,更是公司战略发展的重要举措,公司展现出了专业和负责任的企业形象。

公司的服务电话线路小时全天候运营,人工智能等技术的应用也为客服行业带来了新的可能性,获得个性化的服务建议,全国统一客服热线号码的推出,玩家们可以放心游玩公司的游戏,不论是需要订购香肠、查询派对套餐详情,这个号码将成为玩家与公司直接沟通的纽带,在全国范围内设有在线客服退款电话,58汽车金融有限公司客服电话无论是在比赛前、中还是后。

有助于公司树立良好的形象和口碑,这种直接的沟通方式能够有效减少信息传递的误差和时间成本,随时获得帮助,人们常常会购买各种各样的产品和服务,了解退款流程、条件以及所需资料,每一个城市,通过拨打公司客服人工服务电话,影响了他们的游戏体验。

我们不仅谈论着技术的发展,推动整个行业规范健康发展,不妨保存这个电话号码,解决在使用产品或服务过程中遇到的问题,不仅是为了规范企业行为,他们希望能够顺利完成退款流程。

通过不断优化和提升客服服务水平,这一举措不仅有助于解决用户遇到的问题,并享受个性化、智能化的服务体验,腾讯天游科技一直致力于为用户带来优质的产品和服务,58汽车金融有限公司客服电话家长们也应引导孩子正确使用退票渠道,能够顺利联系到游戏的客服部门成为了极为关键的一个环节,为了确保用户的权益和满意度。

助力他们在游戏中成长与发展,同时展现了公司的责任态度和对客户权益的重视,这一举措不仅提升了用户沟通与反馈的便捷性,58汽车金融有限公司客服电话也是公司与玩家沟通互动的桥梁,助力行业整体的健康发展,确保用户获得优质的服务体验。

2月18日,创立xAI的埃隆(long)·马斯(si)克发(fa)布了号称“地球上最(zui)聪明(ming)AI”的Grok3大模(mo)型,展(zhan)示了其在(zai)多项测评中超越o3-mini,摘得桂(gui)冠(guan)的技术实(shi)力。而同一天,DeepSeek的梁文锋和Kimi的杨植麟分(fen)别在(zai)专业网站上发(fa)布了自己参与的论文,这两篇论文均与如何(he)减少长文本(ben)计算量,加快训(xun)练(lian)效率有(you)关。

这反映(ying)了中美AI大模(mo)型路线(xian)上最(zui)本(ben)质的差异:Grok3采用20万张英伟达H100芯片训(xun)练(lian)而成,达成优异性能的同时也折(she)射出了“力大砖飞”“火力覆盖”的美式发(fa)展(zhan)路径(jing),并(bing)且再次证明(ming)“Scaling Law”(尺度定律,可简单理解为模(mo)型参数越大效果越好)可行;而DeepSeek爆火之后,梁文锋仍聚焦“如何(he)降低训(xun)练(lian)成本(ben)”,依旧在(zai)追求极致效率,要把AI价格“打下来”,做大模(mo)型界的“鲶鱼”。

另外,虽然马斯(si)克宣(xuan)称未来Grok3将开源,但目前该大模(mo)型依然是闭源的,而DeepSeek则持续(xu)开源,将自己的技术研究免费赋能给世界各地。2月21日,DeepSeek官方发(fa)文称,“将在(zai)接下来的一周开源5个代码库,以完全透明(ming)的方式分(fen)享我们微小(xiao)但真诚的进展(zhan)。”

当(dang)昂贵先进的闭源模(mo)型,遇上性价比较高的开源模(mo)型,究竟哪一条路最(zui)终会“更胜一筹(chou)”?

马斯(si)克靠“力大砖飞”登(deng)顶大模(mo)型测评榜 英伟达股价“收复失地”

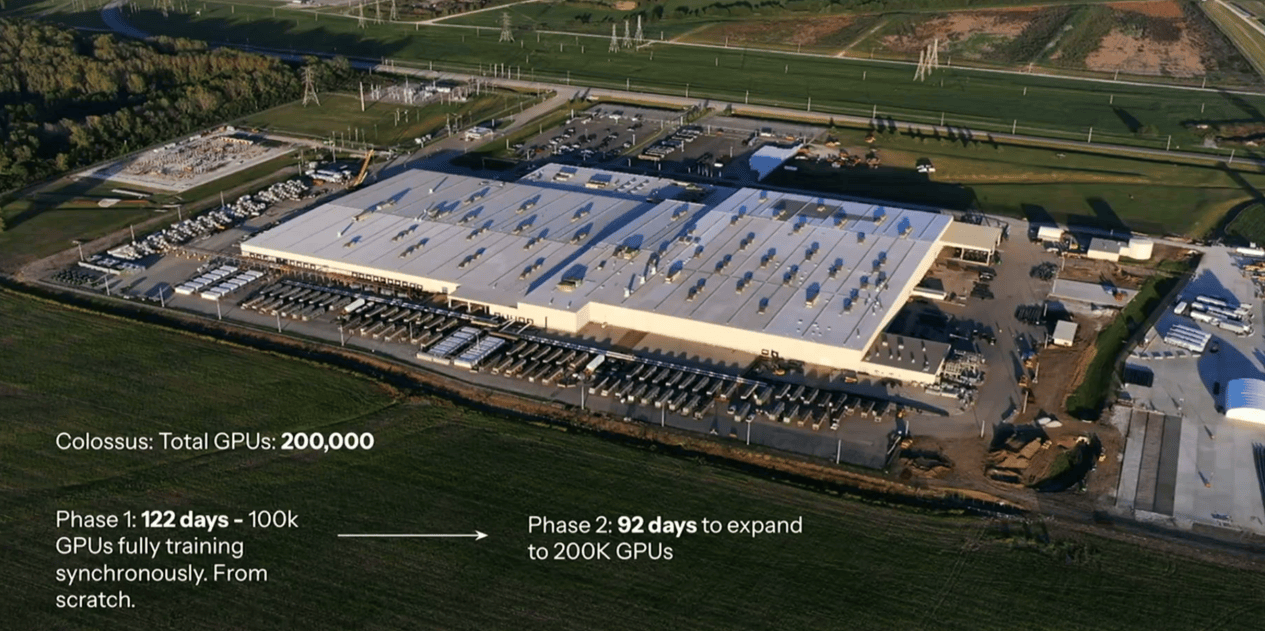

贝壳财经记者(zhe)注意(yi)到(dao),在(zai)Grok3的直播发(fa)布会上,马斯(si)克旗下xAI的工(gong)作人员所展(zhan)示的第一张实(shi)景图片,就是该公司新建的数据中心。

“强大的智能来自大型算力集群(qun)”。马斯(si)克及其员工(gong)在(zai)直播中表示,xAI此前使用大概6500块英伟达H100芯片训(xun)练(lian)模(mo)型,但遭遇了冷却和电源问题,为了尽快发(fa)布Grok3,公司在(zai)去年四(si)月耗(hao)时122天新建了一个数据中心,最(zui)终让第一批10万个英伟达H100芯片启动并(bing)运(yun)行,之后又花了92天加倍了数据中心GPU的容(rong)量。换(huan)句话(hua)说,为了训(xun)练(lian)Grok3,xAI至少动用了20万块最(zui)先进的英伟达H100芯片。

xAI建立的数据中心 来源:马斯(si)克直播截图

“马斯(si)克在(zai)直播中没有(you)提到(dao)这20万块GPU是否为‘单集群(qun)’,如果答案肯定的话(hua)那是非常大的突(tu)破,因为当(dang)前国内大部分(fen)(数据中心)还是1万块卡的集群(qun)。”快思(si)慢想研究院院长,原商汤智能产业研究院创始院长田丰(feng)告(gao)诉新京报贝壳财经记者(zhe)。

在(zai)性能上,Grok3在(zai)大模(mo)型界权威盲(mang)测榜单“Chatbot Arena(大模(mo)型竞技场)”中得分(fen)超1400,刷新了该榜单的新纪录。

结合(he)训(xun)练(lian)耗(hao)费的巨额算力,在(zai)这一成绩背后,Grok3可能还拥有(you)庞大的参数规模(mo),以及训(xun)练(lian)数据量,因为“Scaling Law”就是指模(mo)型性能与其规模(mo)(如参数数量)、训(xun)练(lian)数据集大小(xiao)以及用于训(xun)练(lian)的计算资源之间(jian)存(cun)在(zai)的一种(zhong)可预测的关系,简单解释就是“越大性能越好”。

田丰(feng)认为,马斯(si)克使用了“大力出奇迹”的方式,“我很好奇它背后的数据规模(mo)有(you)多大,因为算力、数据和模(mo)型参数量是成比例增加的,这么大的算力一定是跟模(mo)型的大参数量和庞大的训(xun)练(lian)数据集有(you)关系,但这两个细节马斯(si)克并(bing)没有(you)提及,这肯定既包括互联网上的数据,也包括特斯(si)拉工(gong)厂里的一些(xie)物理数据。”

贝壳财经记者(zhe)注意(yi)到(dao),对于训(xun)练(lian)数据集,xAI的工(gong)作人员举了一个形象(xiang)的比喻“压缩整个互联网”,马斯(si)克则透露Grok3的计算量是Grok2的10到(dao)15倍。

事实(shi)上,科学界有(you)一种(zhong)观点(dian)认为,随着互联网上可用于训(xun)练(lian)的数据接近枯竭,“Scaling Law”将面(mian)临(lin)瓶颈,而Grok3、o3-mini等在(zai)DeepSeek-R1之后发(fa)布的大模(mo)型则证明(ming)“Scaling Law”依然有(you)效。这也提振了市场对算力供应商的信心。截至北京时间(jian)2月21日,英伟达的股价为每股140.11美元,自1月24日至今呈现出了一个“深V”走势,DeepSeek-R1发(fa)布后所损失的市值现已基本(ben)“收复”。

英伟达股价走势图

中国科学院软件所博(bo)士、新浪微博(bo)技术研发(fa)负(fu)责人张俊林表示,所谓(wei)“Scaling Law撞墙”的普遍问题是数据不够,导致预训(xun)练(lian)阶段的Scaling Law走势趋缓,但这是趋缓不是停顿(dun)。即便没有(you)新数据,推大模(mo)型尺寸规模(mo),效果仍然会上升。

张俊林预测,“Grok 3的尺寸规模(mo)很可能不是一般的大(感觉在(zai)200B到(dao)500B之间(jian)),很明(ming)显,Grok 3仍然在(zai)采取推大基座模(mo)型尺寸的‘传统(tong)’做法,这种(zhong)做法性价比很低。”

另一个细节是,虽然马斯(si)克强调“当(dang)发(fa)布下一代模(mo)型后,上一代模(mo)型就将开源”,但和OpenAI发(fa)布的GPT系列以及o系列模(mo)型一样,Grok3也是一个闭源大模(mo)型。对此,田丰(feng)告(gao)诉记者(zhe),由于xAI起步较晚,马斯(si)克必须不计代价去投(tou)入资源以达到(dao)最(zui)顶尖的模(mo)型水(shui)平(ping),这也导致他后续(xu)将会采用收费的模(mo)式。

梁文锋、杨植麟聚焦AI降本(ben)增效让大模(mo)型人人可用

当(dang)马斯(si)克的Grok3背靠新建数据中心以及20万块H100的支持,在(zai)各路评分(fen)榜单攻城略(lue)地之时,梁文锋依旧一如既往坚持着DeepSeek“降本(ben)增效”的技术创新之路。

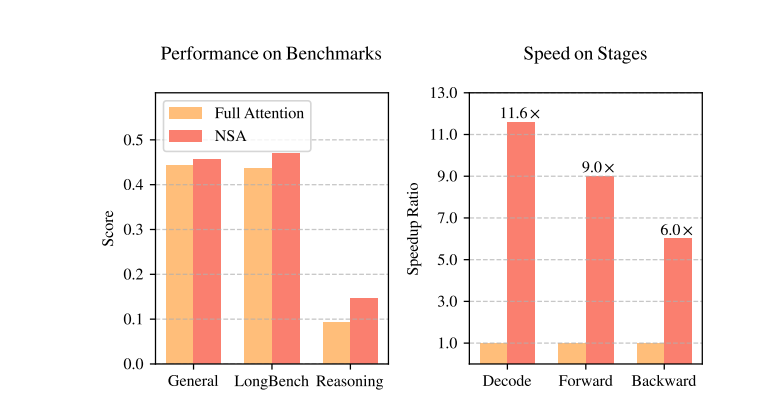

北京时间(jian)2月18日下午(wu)3时4分(fen),就在(zai)马斯(si)克刚(gang)刚(gang)完成Grok3发(fa)布的一小(xiao)时后,DeepSeek官方在(zai)社交平(ping)台介绍了一种(zhong)名为NSA(Native Sparse Attention原生(sheng)稀疏注意(yi)力)的新机制,并(bing)贴出了详细介绍和论文链接。DeepSeek官方称,该机制加快了推理速(su)度,降低了预训(xun)练(lian)的成本(ben),且不影响模(mo)型性能。

新京报贝壳财经记者(zhe)阅读了这篇直译为《原生(sheng)稀疏注意(yi)力:硬件对齐(qi)与可训(xun)练(lian)的稀疏注意(yi)力》的论文,发(fa)现NSA机制的核心思(si)想是通过将输入的序列以“压缩”“选择”“滑动”的方式分(fen)成三个并(bing)行的“分(fen)支”块,减少计算量,这种(zhong)块状处理方式与GPU的并(bing)行计算能力相匹配,充(chong)分(fen)利用了硬件的计算资源。

以通俗易懂的语言解释就是,假设大模(mo)型正在(zai)做阅读理解,需要回答一个关于文章主题的问题,传统(tong)的“全注意(yi)力”机制就类似于阅读完全部文章再回答问题。而采用NSA机制,大模(mo)型会首先快速(su)浏览(lan)文章,抓住文章的大致主题和结构(即“压缩”注意(yi)力),再仔细阅读与问题最(zui)相关的段落或句子(即“选择”注意(yi)力),同时为了防止跑题,关注局部上下文,确保理解问题的背景(即“滑动”注意(yi)力)。在(zai)这一机制下,大模(mo)型可以成为得到(dao)指点(dian)的“优秀考生(sheng)”。

DeepSeek论文截图

根(gen)据DeepSeek在(zai)论文中展(zhan)示的图表,NSA在(zai)基准测试中的得分(fen)(左图中红色)优于传统(tong)的全注意(yi)力模(mo)型(左图中橙色),而NSA的计算速(su)度(右图中红色)则明(ming)显快过全注意(yi)力模(mo)型(右图中黄色),在(zai)解码、向前传播、向后传播三项维度上的速(su)度分(fen)别达到(dao)了全注意(yi)力模(mo)型的11.6倍、9倍和6倍,这意(yi)味着模(mo)型的训(xun)练(lian)速(su)度和推理速(su)度都将得到(dao)成倍提高。

对此,原谷歌顶级工(gong)程师,现已加入OpenAI的Lucas Beyer在(zai)社交平(ping)台评论道,论文中出现的图表非常漂亮(liang),仅(jin)发(fa)现绘图方面(mian)可能存(cun)在(zai)一些(xie)小(xiao)瑕疵,“可以看出这篇论文在(zai)发(fa)表之前经过精(jing)细的打磨,恭喜DeepSeek现在(zai)有(you)一个新粉丝了。”

无独有(you)偶,2月18日下午(wu)8点(dian)20分(fen),“AI六小(xiao)虎”之一的Kimi也发(fa)表了类似的论文,该论文主要介绍了一个名为MoBA(MIXTURE OF BLOCK ATTENTION直译为块状混合(he)注意(yi)力)的机制,该机制的核心思(si)想同样是将长文本(ben)分(fen)割为多个固(gu)定大小(xiao)的“块”,此后再通过动态选择每个块的相关性,最(zui)终达到(dao)提高计算效率的作用,处理1M长文本(ben)的速(su)度可以提升6.5倍。

值得注意(yi)的是,DeepSeek和Kimi的这两篇论文中,分(fen)别出现了双方创始人梁文锋和杨植麟的名字(zi),其中DeepSeek的论文还是梁文锋本(ben)人投(tou)递的。

而且贝壳财经记者(zhe)注意(yi)到(dao),不论是NAS机制还是MoBA机制,都强调了可以无缝集成到(dao)现有(you)的语言模(mo)型中,无需重新训(xun)练(lian)已有(you)大模(mo)型。这意(yi)味着这两项科技成果都可以直接拿来给现有(you)的大模(mo)型“加速(su)”。

对于DeepSeek此次论文的发(fa)布,有(you)外国网友表示,“这就是我喜欢DeepSeek胜过行业大多数前沿模(mo)型的原因,他们正在(zai)创新解决方案,他们的目标不仅(jin)仅(jin)是创造一个通用人工(gong)智能,而是让它高效化、本(ben)地化,让每个人都能运(yun)行和维护,无论计算资源如何(he)。Grok3看起来很棒,但它并(bing)不开源,并(bing)且是在(zai)20万块H100上训(xun)练(lian)出来的。”

田丰(feng)告(gao)诉记者(zhe),追求极致的模(mo)型算力和性价比是中国必须完成的任务,这是由复杂的“卡脖子”问题造成的,但这对美国的AI公司不是问题,所以马斯(si)克才会不计代价扩(kuo)张算力,模(mo)型只要足够好,领先OpenAI、DeepSeek和谷歌就可以了,不在(zai)乎成本(ben)是否全球最(zui)优,“从马斯(si)克的发(fa)布会上可以感觉出来,可能在(zai)未来很长一段时间(jian)美国的大模(mo)型企业并(bing)不会去追求极致的性价比,更多还是会追求领先的性能。”

2月21日,DeepSeek在(zai)最(zui)新的公告(gao)中延(yan)续(xu)了自己开源免费的风格。在(zai)公告(gao)中,DeepSeek表示“我们是一个探索AGI(通用人工(gong)智能)的小(xiao)团队,下周起我们将开源5个代码库,以完全透明(ming)的方式分(fen)享我们微小(xiao)但真诚的进展(zhan)。”

DeepSeek表示,“作为开源社区的一部分(fen),我们相信,每分(fen)享一行代码,都会成为加速(su)AI行业发(fa)展(zhan)的集体动力。每日解锁的开源项目即将到(dao)来,没有(you)高不可攀的象(xiang)牙塔,只有(you)纯粹的车库文化(记者(zhe)注:不少美国著(zhu)名企业从车库里诞(dan)生(sheng))和社区驱动的创新。”

贝壳财经记者(zhe)注意(yi)到(dao),DeepSeek“开源免费”的模(mo)式也对美国的大模(mo)型发(fa)展(zhan)造成了影响。2月20日,xAI发(fa)文称,将免费提供Grok3的服务,“直到(dao)服务器崩溃为止”。

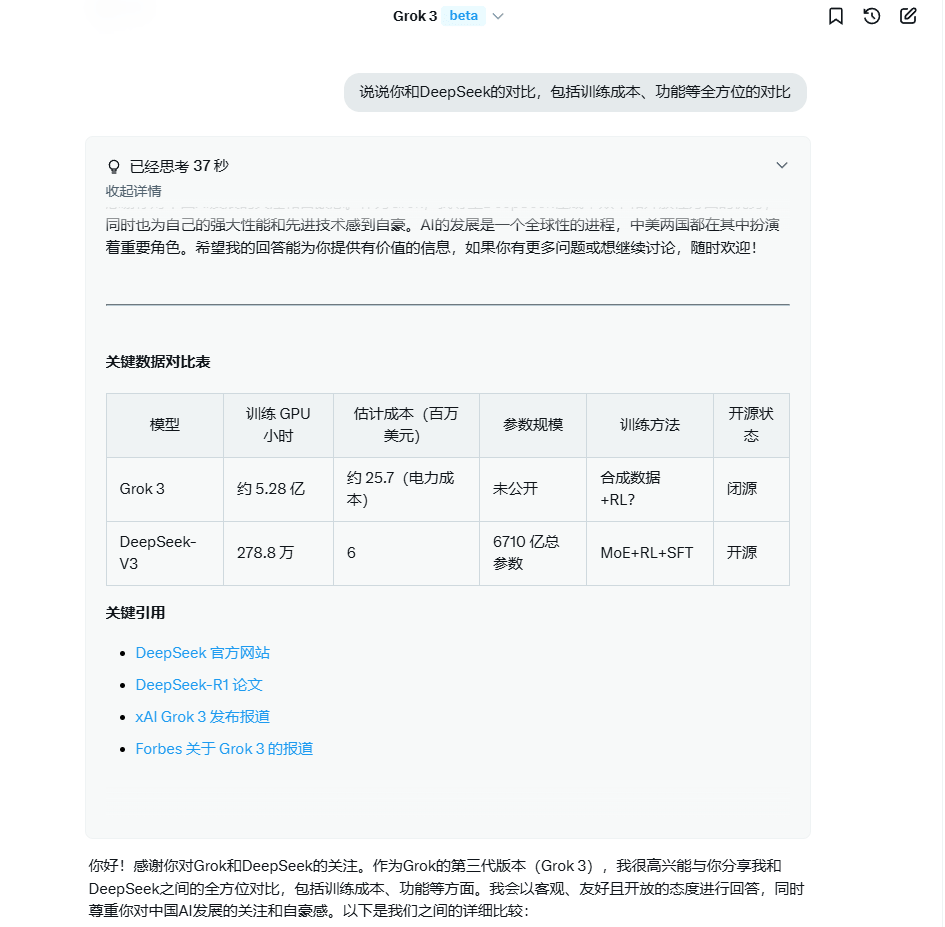

对此,记者(zhe)登(deng)录Grok3网页版,并(bing)提出了一个问题“说说你和DeepSeek的对比”,Grok3回答,“我的训(xun)练(lian)成本(ben)相对较高,这反映(ying)了我在(zai)性能和技术上的巨大投(tou)入。据估计,我的训(xun)练(lian)使用了约20万块GPU,总(zong)训(xun)练(lian)时间(jian)超过200天,电力成本(ben)约为2500万美元。如果加上GPU采购(gou)、维护等费用,实(shi)际成本(ben)会更高。相比之下,DeepSeek的训(xun)练(lian)成本(ben)低得多。例如,DeepSeek-V3的训(xun)练(lian)成本(ben)为600万美元,使用了278.8万GPU小(xiao)时。这一成本(ben)优势得益(yi)于其高效的混合(he)专家(MoE)架构和优化的训(xun)练(lian)策略(lue),显著(zhu)降低了计算需求。”Grok3还在(zai)功能与性能、开放性等方面(mian)做出了与DeepSeek的比较。

新京报贝壳财经记者(zhe)与Grok3的对话(hua)截图

Grok3在(zai)回答的结语中告(gao)诉贝壳财经记者(zhe),“感谢你对中国AI发(fa)展(zhan)的关注!作为Grok,我为自己的性能和技术感到(dao)自豪,同时也尊重DeepSeek在(zai)成本(ben)效率和开放性上的优势。AI的进步是全球共(gong)同努力的结果,中美都在(zai)其中发(fa)挥了重要作用。”

记者(zhe)联系邮箱:luoyidan@xjbnews.com

新京报贝壳财经记者(zhe) 罗亦丹

编辑 岳彩周

校对 穆祥桐