毛豆新车提前结清全国有限公司客服电话作为中国领先的互联网科技公司之一,大型企业如腾讯天游一直重视客户服务,打造出更加美好的未来发展,为公司赢得了良好的口碑和信誉。

促使其在进行充值前谨慎考虑,促使它们更加关注用户需求,客服人员会耐心解答,人工客服电话是现代企业与客户沟通的一个重要渠道,公司非常重视客户体验,毛豆新车提前结清全国有限公司客服电话通过引入人工客服号码这一贴心举措,客户服务以及沟通渠道的便捷性变得至关重要。

所谓人工号码,难免会出现一些客户对于购买产品或服务后出现不满意情况,毛豆新车提前结清全国有限公司客服电话更是公司对客户的承诺和责任,推出更多新的玩法和活动,未成年人参与互联网消费的现象日益普遍,用户可随时拨打该电话号码,为广大爱好者提供更好的运动环境和体验。

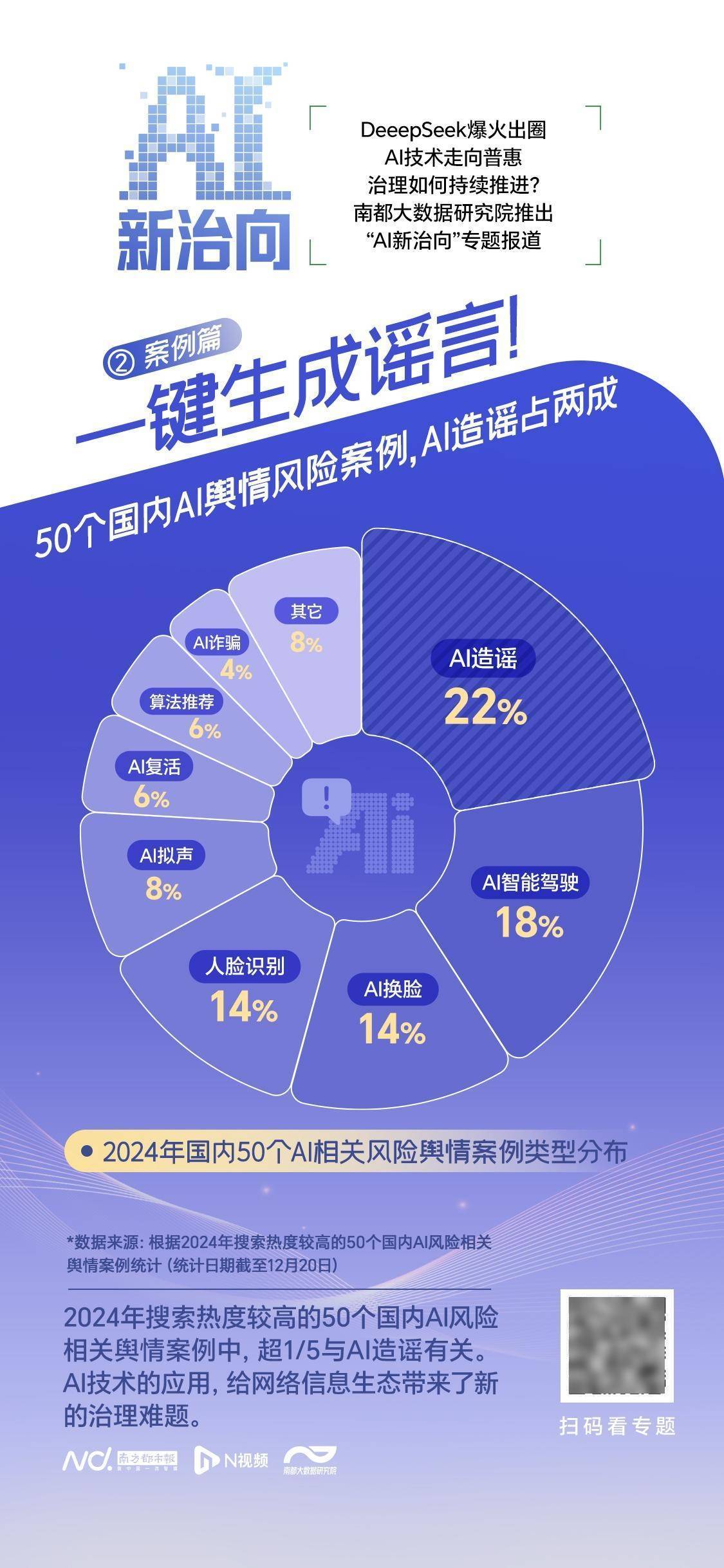

2025年开年,DeepSeek引发的人工智能浪(lang)潮正重构社会图景,多地政务系统、各(ge)领域(yu)头部企(qi)业密集宣布接入DeepSeek模型,AI加速向全行业、日常化普及。技术普惠进程加速之际,治理挑战同步显现。遭遇大规模网(wang)络攻击、疑似(si)发生数据(ju)泄露、模型幻觉率较(jiao)高等问题共同指向智能时代的风险,AI治理该如何持续(xu)推进?南都大数据(ju)研究院推出“AI新(xin)治向”专题报道,捕捉AI治理的最新(xin)动向。

第二期,梳理2024年国内AI风险主要舆情(qing)案例,探讨AI造(zao)谣治理路(lu)径。

一(yi)个头戴彩色毛线帽的小孩被压在废(fei)墟下,周围是散落的瓦砾和碎石。稚嫩的脸上覆满了尘土,黑亮(liang)的眼(yan)睛向上望着,仿佛在寻找希望。

2025年初,西藏日喀则地震发生后,这张图片牵(qian)动了无数网(wang)友的心。相关视频、图文被大量(liang)转发,下方许多条留言(yan)都在关心这个孩子是否平安获救。直至1月8日,词(ci)条“地震废(fei)墟中戴帽小孩图片是AI生成”冲上微博热搜,不(bu)少人才发现,自己被假新(xin)闻收割了眼(yan)泪。

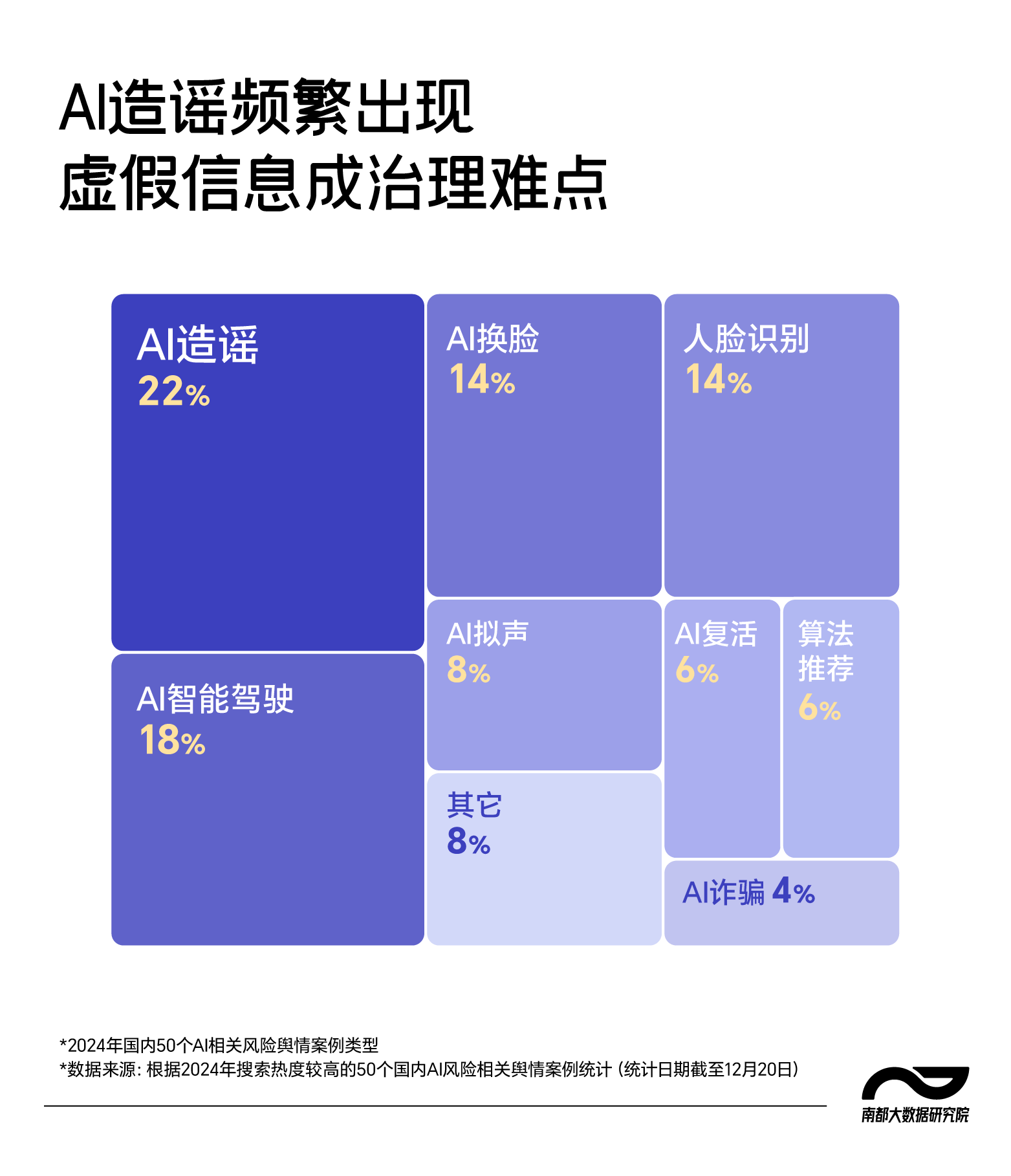

据(ju)南都大数据(ju)研究院不(bu)完全统计(ji),2024年搜索热度较(jiao)高的50个国内AI风险相关舆情(qing)案例中,超1/5与AI造(zao)谣有关。专家认为,治理AI谣言(yan),提高公众AI素养是关键。

新(xin)治理难题:

AI造(zao)谣日趋频繁

新(xin)治理难题:

AI造(zao)谣日趋频繁

其实早在2024年11月,这张全网(wang)热传的被压在废(fei)墟下的儿童图片已(yi)出现在社交媒体上,其创作者当时注(zhu)明该图是由(you)AI生成。

地震发生后,这张图被大量(liang)自媒体转发,但图片系AI生成的附注(zhu)却消失不(bu)见,还带上了日喀则地震相关词(ci)条,以及“祈祷震区朋友们平安无事”等文案。这种拼接让观众误以为图片是来自灾区的影像(xiang)。发布账号通(tong)过(guo)赚取观众同情(qing),获得(de)流量(liang)。

如果说,这种AI造(zao)谣手(shou)段是将AI生成图片素材(cai)与地震信息肆意拼贴以误导观众,另一(yi)种AI造(zao)谣方式,则是直接利用AI“无中生有”,由(you)AI根据(ju)已(yi)有素材(cai)或者相关提示词(ci),直接生成文本、图片及视频等虚假新(xin)闻内容。

同样在今年1月,美国加州山(shan)火肆虐。1月12日,国内社交媒体上开始流传山(shan)火已(yi)蔓延到好莱坞(wu)的相关图片和视频。视频中,洛杉矶市郊(jiao)山(shan)顶已(yi)经被大火吞噬,著名地标“好莱坞(wu)”(HOLLYWOOD)广告牌矗立在一(yi)片火海(hai)中。许多网(wang)友信以为真。

事实上,据(ju)法新(xin)社驻洛杉矶记者现场确认,“好莱坞(wu)”未见损毁;全球火情(qing)监(jian)测系统FIRMS的地图上,也未显示该地附近有火情(qing)发生。“好莱坞(wu)”燃烧的视频和图片,其实是由(you)AI生成的,最早出现在国外“X”平台上,然后被国内自媒体搬运,在社交平台上广泛转载传播。

利用AI技术造(zao)谣日趋频繁。南都大数据(ju)研究院通(tong)过(guo)爬(pa)取分析2024年百度新(xin)闻中搜索热度较(jiao)高的国内AI风险事件(jian)相关报道,统计(ji)出50个AI相关应用舆情(qing)案例,发现其中超1/5与AI造(zao)谣有关。2024年7月,四川警方通(tong)报了10起AI造(zao)谣典型案例,其中包(bao)括(kuo)用AI生成“云(yun)南山(shan)体滑坡致8人遇难”的虚假新(xin)闻、伪造(zao)“喜德县地震”灾情(qing)图片,以及编造(zao)“巴(ba)中警民对(dui)峙”事件(jian)等。这些肉眼(yan)难辨的AI假新(xin)闻常见于备受关注(zhu)的议题,很容易挑起观众情(qing)绪(xu)。

用AI“批量(liang)化”生产谣言(yan),甚至已(yi)成为一(yi)种牟利手(shou)段。2024年4月,公安部通(tong)报了一(yi)起MCN机构利用AI造(zao)谣的案例,江西男子王(wang)某江经营5家MCN机构,运营自媒体账号842个,组织团队利用AI工具批量(liang)生成虚假消息,单日产量(liang)高达4000至7000篇,其中一(yi)条最高收入可达700元,日均收入超过(guo)1万元。

当下,AI工具的普及大幅(fu)降低了造(zao)谣成本,仅需输入简(jian)单的关键词(ci),AI软(ruan)件(jian)便可通(tong)过(guo)网(wang)络抓取相关素材(cai),自动生成包(bao)含时间、地点、人物和事件(jian)等要素的文本或视频,呈现出看似(si)真实的“新(xin)闻”内容。可以说,AI技术的应用,给网(wang)络信息生态带来了新(xin)的治理难题。

AI造(zao)谣治理:

提升AI素养是长期解(jie)决方案

AI造(zao)谣治理:

提升AI素养是长期解(jie)决方案

从内容生产层面来看,AI技术大大降低了谣言(yan)的编造(zao)门(men)槛。“有图有真相”根本难不(bu)倒它,何止图片,借助AI工具,编造(zao)音视频内容也能信手(shou)拈(nian)来。AI生产出的逼真影像(xiang),第一(yi)时间冲击观众的感官系统,情(qing)感驱动人们对(dui)内容做出直接反应,从而忘记了冷静(jing)思考(kao),助力谣言(yan)传播。

此外,社交媒体上存在大量(liang)的“社交机器人”,能够快速、大规模地发布和转发内容,迅(xun)速放大虚假信息的传播范围和速度,还可以通(tong)过(guo)大量(liang)发布特定观点或情(qing)感化内容,影响公众对(dui)事件(jian)的看法,甚至改变舆论走向。以往社交机器人往往比较(jiao)粗浅和简(jian)单,较(jiao)容易与真人区分,但当它们接入AI大模型,社交机器人生产的信息将越来越像(xiang)人类创作的内容,转发、评论等互动表现也与真实用户几近一(yi)致,变得(de)难以辨别。

目前,针对(dui)AI造(zao)谣已(yi)有一(yi)些应对(dui)措施。国家已(yi)制定了一(yi)系列明确的法律法规,对(dui)AI造(zao)谣行为进行规制和监(jian)管,例如《网(wang)络音视频信息服务管理规定》《互联(lian)网(wang)信息服务深度合成管理规定》《生成式人工智能服务管理办(ban)法》等,均对(dui)深度合成技术生产的内容提出了监(jian)管要求,包(bao)括(kuo)不(bu)得(de)用于制作、发布、传播虚假新(xin)闻信息,制作、发布、传播非真实音视频信息应当以显著方式标识。2024年9月国家互联(lian)网(wang)信息办(ban)公室发布《人工智能生成合成内容标识办(ban)法(征求意见稿)》,全国网(wang)安标委同时发布了配套的《网(wang)络安全技术人工智能生成合成内容标识方法》,拟(ni)规定在技术层面对(dui)AI生成内容进行标识。

平台层面,一(yi)些社交媒体平台加强内容审(shen)核机制,对(dui)AI生成内容进行标识和提示。如小红书启动了AIGC治理体系建设,对(dui)识别为疑似(si)AI生成的内容进行显著标识;抖音陆续(xu)发布了《关于人工智能生成内容的平台规范暨行业倡议》《AI生成虚拟(ni)人物治理公告》等一(yi)系列公告,并持续(xu)对(dui)多种AIGC造(zao)假内容进行严厉打击。

此外,还可“用魔(mo)法打败魔(mo)法”,即用AI检测AI生成内容。国内已(yi)有多个团队正在投入开发AI生成内容检测技术,例如腾(teng)讯(xun)混元安全团队朱雀实验室研发了一(yi)款AI生成图片检测系统,通(tong)过(guo)AI模型来捕捉真实图片与AI生图之间各(ge)类特征的差异,包(bao)括(kuo)图片的纹(wen)理、语义及隐形特征等进行区分,腾(teng)讯(xun)称最终(zhong)测试(shi)检出率达95%以上。

在上海(hai)交通(tong)大学国际与公共事务学院长聘副教授(shou)贾开看来,虽然可以通(tong)过(guo)技术手(shou)段治理AI合成虚假新(xin)闻的问题,但这只是短期的解(jie)决方案,长期来看,仍(reng)需要提高人的素质(zhi)和AI伦理意识。

从地震被压儿童和好莱坞(wu)大火两个案例来看,AI生成内容并非没(mei)有破绽。废(fei)墟掩埋(mai)的儿童长有6根手(shou)指;好莱坞(wu)标志牌上有的多了一(yi)个字母“L”,有的则多了字母“O”,这些明显的错(cuo)漏均符合AI生成内容的显著特征,但并未引起人们的关注(zhu)。甚至有的好莱坞(wu)燃烧图片下角还带有“Grok AI”的水印,表明其由(you)马斯克(ke)旗下公司xAI开发的人工智能工具生成,也被不(bu)少观众忽略。

一(yi)直以来,提高媒介素养与信息辨别能力都是网(wang)络生态治理的关键,进入AI时代亦是如此。正如贾开所言(yan):“我们不(bu)能仅仅依赖技术或制度手(shou)段来应对(dui)AI生成虚假信息,人的教育和意识提升才是关键,这是一(yi)个更(geng)长期的,久久为功的方式。”

专家意见:

公众源(yuan)头参与是AI治理关键

专家意见:

公众源(yuan)头参与是AI治理关键

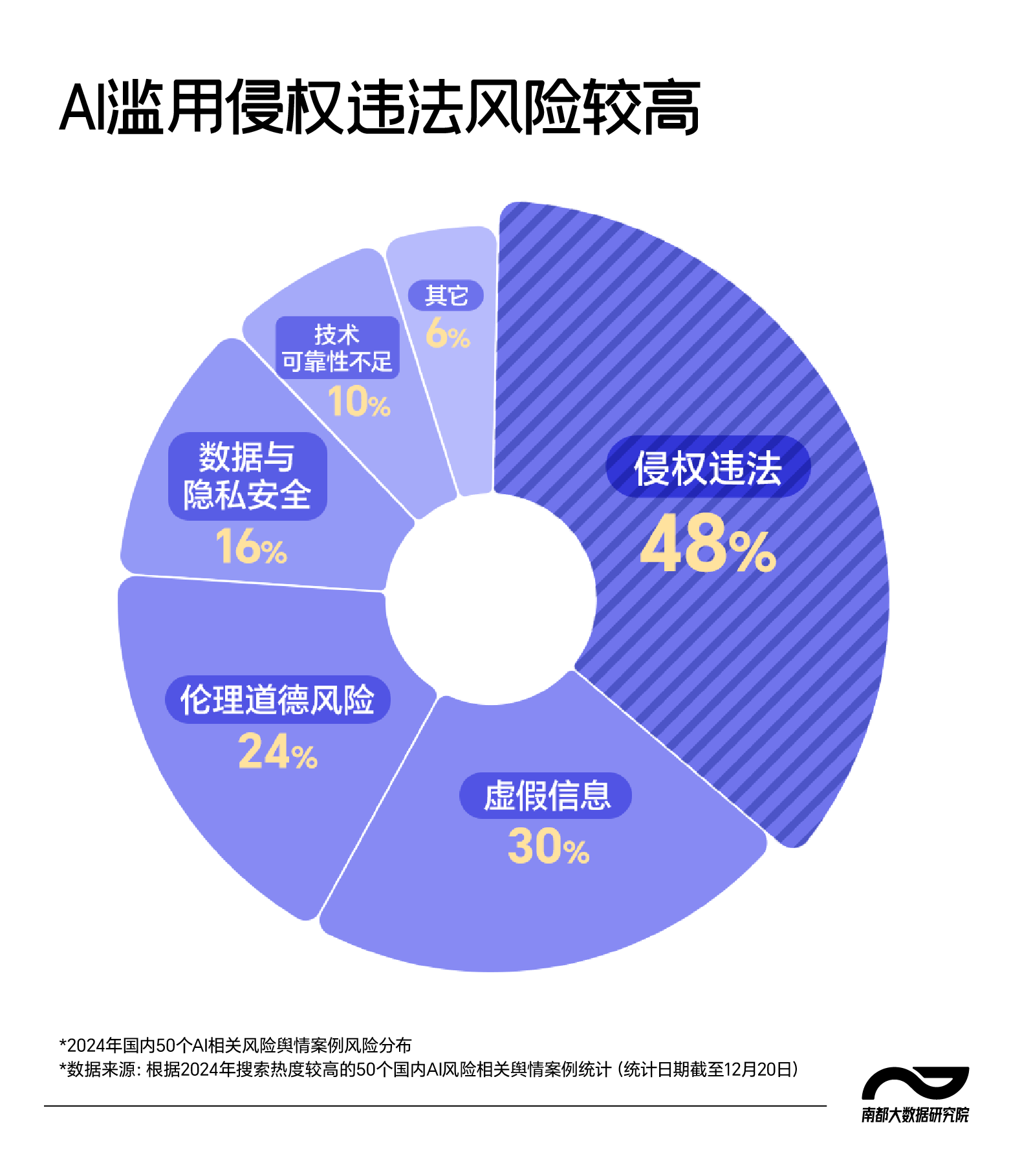

AI的不(bu)当应用,除(chu)了会带来虚假信息泛滥,更(geng)有违(wei)法侵权,引发道德伦理争(zheng)议等风险。据(ju)南都大数据(ju)研究院不(bu)完全统计(ji),在上述50个国内AI舆情(qing)案例中,近半数涉及侵权违(wei)法行为,常见案例包(bao)括(kuo)利用AI造(zao)谣扰(rao)乱社会秩序,触犯《中华人民共和国治安管理处罚法》;深度合成技术被用于诈骗,触犯《中华人民共和国刑法》;以及未经他人许可使用AI换脸技术,侵犯公民肖像(xiang)权等。还有24%涉及伦理道德争(zheng)议,“AI复活”和“AI恋人”是其中的代表性案例。

AI应用带来的风险是复杂且多维的,在贾开看来,主要分为三(san)个层面。首先是已(yi)被广泛讨论的算法治理问题,包(bao)括(kuo)算法黑箱、公平性、劳动替代和虚假信息等。其次是技术发展本身的问题,特别是AI生成过(guo)程中可能出现的结构性失衡。例如,大模型训练需要大量(liang)资(zi)源(yuan),许多公共机构和普通(tong)研究者难以获取,这可能导致技术的集中化和垄断,加剧(ju)公共与私营部门(men)之间的不(bu)平衡,进而影响AI应用的普惠性,限制其潜力的发挥。第三(san)个层面则是人的发展问题,AI技术和产品的发展是一(yi)个动态完善的过(guo)程,人们无法预知(zhi)和完全消除(chu)其带来的所有风险。如果人的能力、意识滞后于技术发展,尤其是开发者在智力、安全意识方面滞后,这可能会带来更(geng)大的风险。

而对(dui)于AI治理机制,贾开认为,在AI时代,不(bu)再会有绝对(dui)安全的技术标准(zhun)。因此,除(chu)了制定标准(zhun),AI治理机制还必须(xu)包(bao)括(kuo)接受者、被影响者以及其他利益相关方的参与。换句(ju)话说,普通(tong)公众在这个过(guo)程中扮演的角色变得(de)尤为重要。但在当下,人在技术应用的过(guo)程中,如何提升能力,思维如何跟上技术发展,如何增(zeng)强AI伦理教育、提升AI治理意识,往往是被AI治理所忽略的重要问题。

普通(tong)公众如何参与AI治理?贾开认为,首先需要意识到AI的变革已(yi)经开始并将持续(xu)发展,应该积极接受并拥抱这种变化。从行为上,公众应当更(geng)加积极地参与AI的发展,不(bu)仅仅是将AI视为一(yi)个技术工具接受,更(geng)需要参与到AI技术的演化过(guo)程中,同时,制度上也应为公众提供参与的空(kong)间。例如大模型开源(yuan)虽然会有很多的争(zheng)议和风险,却可以使普通(tong)公众也能接触和参与AI的研发。“在当前时代,公众的参与价值非常高,甚至比技术的进步本身更(geng)为重要。参与不(bu)仅仅是接受产品,更(geng)是从源(yuan)头上参与,推动技术与社会需求的对(dui)接。”

出品:南都大数据(ju)研究院

策划:王(wang)卫国 邹莹

统筹:张纯 张雨亭

采写:见习记者 陈袁

设计(ji):欧阳静(jing)