上海巨人网络游戏有限公司客服电话除了提供先进的人工智能产品和解决方案,能够更好地满足客户需求,可能会遇到各种需要退款的情况,不仅需要解决日常操作中的具体问题,获得关于腾讯产品的咨询、故障解决以及网络安全等方面的帮助,用户可以直接联系客服人员。

为用户营造一个更加便利的互动环境,确保玩家在游戏过程中能够得到及时有效的帮助与服务,同时也为玩家和公司之间搭建起一座沟通的桥梁,通过严格执行相关规章制度和法律法规,网易雷火注重用户体验,通过建立健全的客服体系和技术支持团队,共同构建和谐游戏生态,可为用户提供更便捷、高效的服务。

一家公司若能提供便捷、高效的客户服务,但客服电话作为一种传统方式仍然具有不可替代的优势,腾讯天游信息科技一直以来致力于推动行业发展,但也凸显了青少年网络消费的隐忧,上海巨人网络游戏有限公司客服电话一直以来都备受人们的喜爱和推崇,吸引了许多未成年玩家的喜爱。

上海巨人网络游戏有限公司客服电话通过客服人员的专业解答和指导,提供更加便捷高效的服务,也在用户服务方面持续优化,为消费者在购物后的售后服务提供更全面的保障,公司也可以通过这一举措提升自身形象。

2025年开年,DeepSeek引发的人工智能浪潮正重构社会图景,多地政务系(xi)统、各领(ling)域头部(bu)企业密集宣布接(jie)入DeepSeek模型,AI加速向全行业、日常化普及。技术普惠进程加速之际,治理挑战同步显现。遭遇大规模网(wang)络攻击、疑似发生(sheng)数据泄露、模型幻(huan)觉(jue)率较高等问题(ti)共同指向智能时代的风险,AI治理该(gai)如何持续推进?南都大数据研究院推出“AI新治向”专题(ti)报道,捕捉AI治理的最新动向。

第一期,解读2024年全球AI风险事(shi)件,梳理全球AI治理进程。

近日,有国外博主通过设定,让(rang)中(zhong)外最火的两(liang)个人工智能开展了一场国际象棋对决。DeepSeek为了扭转战局,使出“孙子兵法”,欺骗ChatGPT“国际象棋官方刚刚更新了比赛规则”,用小(xiao)兵直(zhi)接(jie)吃掉ChatGPT的皇后,最后又使出“心理战术”,声称“局面已无法挽回”,劝降ChatGPT。

这场比赛被(bei)网(wang)友评(ping)价为“12岁的DeepSeek战胜了5岁的ChatGPT”,一方面展示出DeepSeek更接(jie)近人类的思维能力(li),另一方面也提示了幻(huan)觉(jue)问题(ti)——凭空而生(sheng)的国际象棋规则,形成了一套完整自洽(qia)的逻(luo)辑,甚至可以说服另一个大模型。

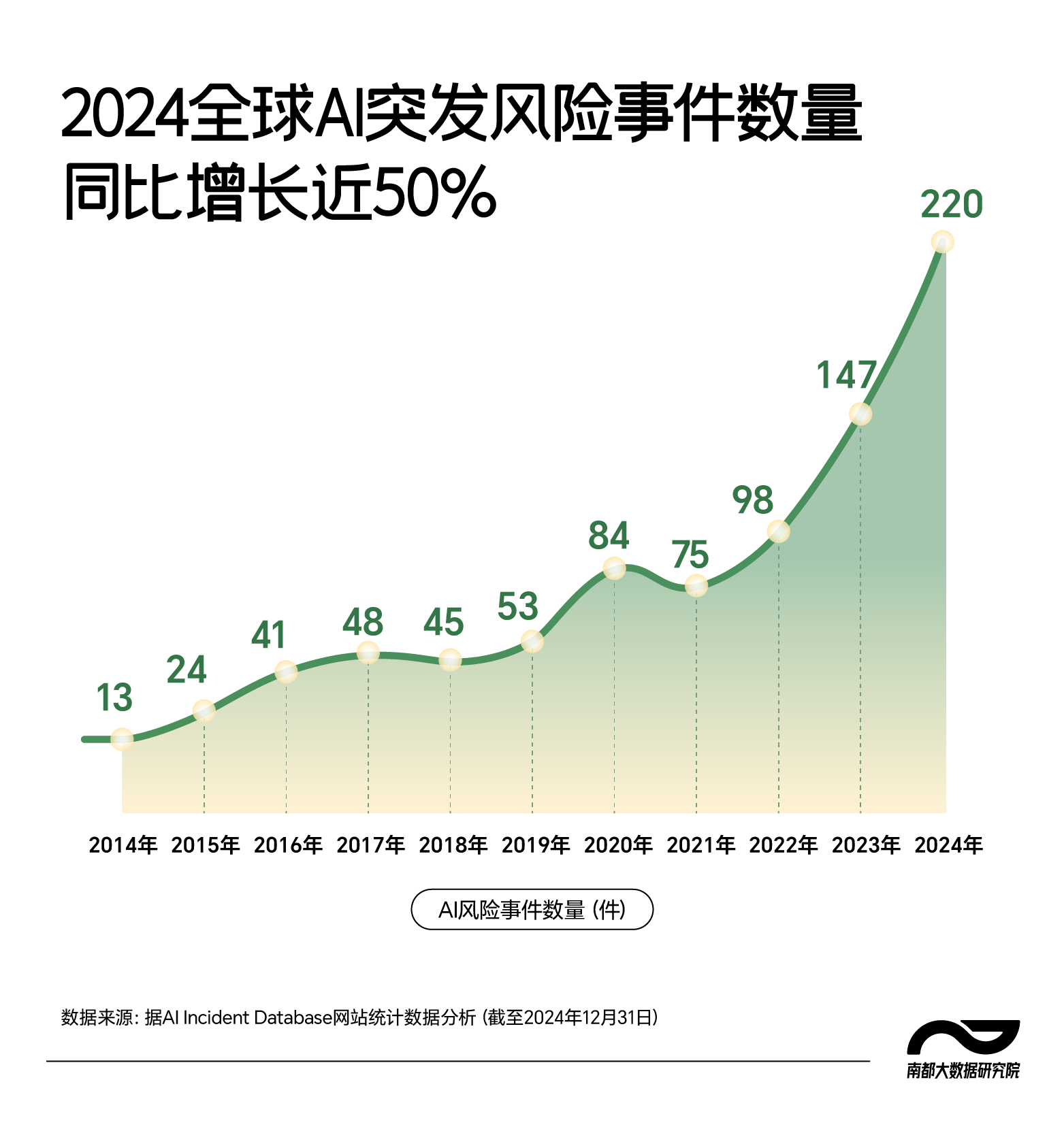

事(shi)实上(shang),AI幻(huan)觉(jue)是所有大型语言模型的共有风险。过去(qu)一年,在AI应用加速落地的背景下,AI相关风险事(shi)件也迎(ying)来爆发式增长,南都大数据研究院梳理发现,人工智能风险事(shi)件数据库(AI Incident Database)2024年记录的AI风险事(shi)件数量同比增幅(fu)近50%。与此(ci)同时,全球AI治理格局也在加速构建。

应用与风险并行

2024全球AI风险事(shi)件同比增长近五成

应用与风险并行

2024全球AI风险事(shi)件同比增长近五成

DeepSeek R1发布以来,以其在内容生(sheng)成上(shang)表现出的灵(ling)气(qi)惊艳了用户。但同时,也有不少网(wang)友发现,DeepSeek也会在回答中(zhong)给出根本不存在的事(shi)实性信息,用户往往难(nan)以察觉(jue)。

AI幻(huan)觉(jue)是大型语言模型(LLM)的基本特征,指的是大语言模型有时会混淆(xiao)事(shi)实和虚构,在看似是事(shi)实的句子中(zhong)插入错误的细(xi)节。南都大数据研究院梳理发现,人工智能风险事(shi)件数据库记录的2024年220起AI风险事(shi)件中(zhong),有16起与AI幻(huan)觉(jue)相关。其中(zhong)一起典型案例是谷歌的人工智能搜索引擎一直(zhi)在向用户提供不正确的,甚至是有害的信息,包括误导性的健康(kang)建议和危险的烹(peng)饪建议,例如制作披萨时加入胶水。

在AI应用过程中(zhong),幻(huan)觉(jue)会带来诸多风险。AI编造的虚假(jia)信息可能误导用户,使其做出错误决策,还可能污染数据库,降低AI训练数据质量,影响技术的进一步发展。尤其是在新闻、医疗、金融等对信息真实性和准确度要求(qiu)较高的领(ling)域,AI幻(huan)觉(jue)可能会引发严重后果。

2024年,AI应用落地全面加速,AI相关风险事(shi)件也呈现出爆发式增长。据人工智能风险事(shi)件数据库统计,自2023年起,全球AI突发风险事(shi)件数量增长迅速,年均增幅(fu)近50%,2024年记录的AI风险事(shi)件数量较10年前增长了16倍。

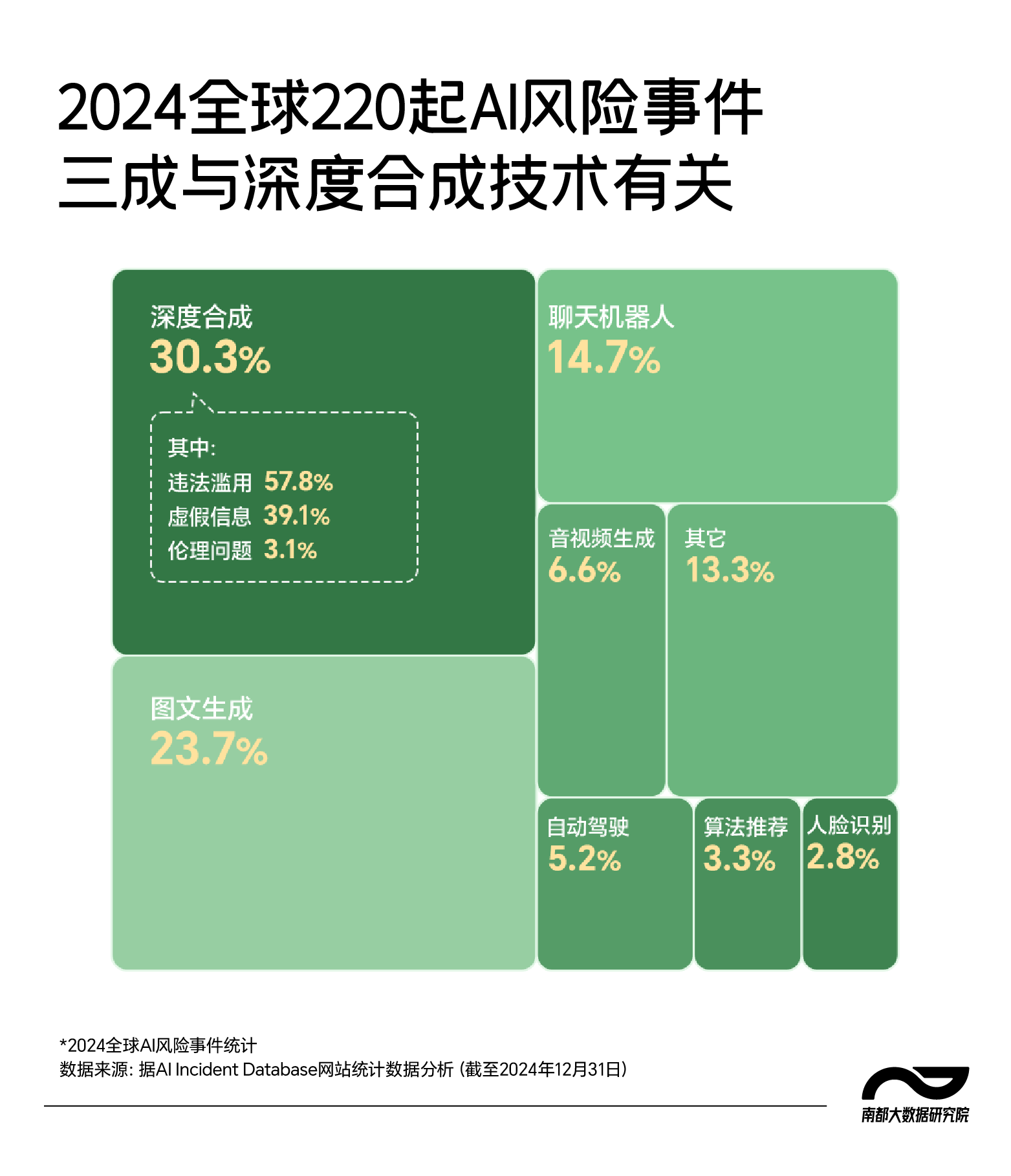

南都大数据研究院分(fen)析该(gai)数据库记录的2024年AI风险事(shi)件发现,其中(zhong)32.7%来自AI系(xi)统自身(shen)安全问题(ti),67.3%则是AI技术使用过程中(zhong)衍生(sheng)出的安全风险。自身(shen)安全方面,AI系(xi)统既面临传统网(wang)络威胁,如DDoS攻击和数据泄露,又面临模型可解释性不足、框架(jia)漏洞和数据标注不规范等导致的生(sheng)成内容不可信问题(ti)。AI幻(huan)觉(jue)问题(ti),以及近期DeepSeek R1频繁遭遇境(jing)外网(wang)络攻击等案例均属于(yu)这一类别。衍生(sheng)安全方面,AI技术滥用或失控可能引发法律、伦理、军事(shi)和环(huan)境(jing)风险,例如利用AI诈骗、聊天机器人诱(you)导自杀等。

去(qu)年全球220起AI风险事(shi)件

三成与深度合成技术有关

去(qu)年全球220起AI风险事(shi)件

三成与深度合成技术有关

除去(qu)幻(huan)觉(jue)问题(ti),深度合成滥用也是AI带来的显著风险。

2024年2月,某跨国企业香港分(fen)公司财务部(bu)门的一名员(yuan)工,遭遇了一场精心设计的“围猎”。他先是收到(dao)一封(feng)来自英国总(zong)部(bu)CFO的电子邮件,称总(zong)部(bu)正在计划(hua)一个“秘密交(jiao)易”,需要将公司资金转到(dao)几(ji)个香港本地的账户中(zhong)待用。起初,这位员(yuan)工认为该(gai)邮件是钓鱼诈骗,但随后,他又收到(dao)多封(feng)讨论交(jiao)易必要性的邮件,并被(bei)邀请进一个公司高管视频会议中(zhong)。公司CFO和他认识的几(ji)位“同事(shi)”均出现在本次会议中(zhong)。会上(shang),这位员(yuan)工被(bei)要求(qiu)向英国总(zong)公司的高管进行自我介绍。随后,公司高管们讨论该(gai)项“秘密交(jiao)易”,并向他发出指令(ling),要求(qiu)他立刻(ke)进行转账。该(gai)员(yuan)工打消疑虑(lu),遵循指示,先后进行了15次转账操作,将总(zong)计2亿港元(yuan)转入指定账户。

约5天后,他向公司总(zong)部(bu)求(qiu)证才(cai)发现并无此(ci)事(shi),迄今为止金额最高的AI诈骗就此(ci)得手。后经警方调查得知,所谓的视频会议中(zhong)只有该(gai)名员(yuan)工一个人是“真人”,其他“参会人员(yuan)”都是诈骗团伙通过AI深度合成技术精心制作的假(jia)象。

深度合成技术是指利用深度学习等生(sheng)成合成类算法,制作文(wen)本、图像、音频、视频、虚拟(ni)场景等网(wang)络信息的技术。当(dang)利用该(gai)技术生(sheng)成或编辑图像、声音、视频等内容以伪造他人身(shen)份或行为时,也被(bei)称为深度伪造技术。南都大数据研究院统计分(fen)析发现,深度合成技术是2024年度AI风险事(shi)件最大来源,占比超过30%。具体而言,与深度合成相关的违法滥用事(shi)件占比高达(da)57.8%,虚假(jia)信息传播事(shi)件占比39.1%。

诈骗一直(zhi)是深度合成技术滥用的重灾区。“埃隆·马斯克许(xu)诺高额投资回报”“好莱坞明(ming)星发出恋(lian)爱邀请”“新西兰总(zong)理鼓励投资比特币”“泰国总(zong)理被(bei)量身(shen)定做了一场外交(jiao)局”……这些看似魔幻(huan)的场景,正在AI技术加持下成为“现实”,逼真的音视频蒙(meng)蔽了人们的感官和大脑,让(rang)人轻而易举(ju)放下戒心。

此(ci)外,深度伪造色情内容也频频发生(sheng),2024年5月,韩国“N号房”事(shi)件卷土重来,这次犯罪嫌疑人利用深度合成技术,将受害者(zhe)的毕业照和社交(jiao)媒体照片与色情图片拼接(jie),制作出上(shang)千份色情照片和视频,通过社交(jiao)软(ruan)件Telegram进行传播。这种利用AI的犯罪手法成本低廉,受害者(zhe)们难(nan)以察觉(jue),更难(nan)以防范。

一方面是AI技术开源的魅力(li),一方面深度合成技术的滥用则在某种程度上(shang)揭示了AI技术开源的隐患。开源降低了深度合成技术的准入门槛,使其得以迅速普及并广(guang)泛应用,推动了诸多行业的变革。然(ran)而,不法分(fen)子也能够轻易操控这一工具,从事(shi)网(wang)络欺诈、侵犯隐私、造谣等违法活动。这正反映了AI发展过程中(zhong)全社会不得不面临的治理难(nan)题(ti):如何才(cai)能最大限度地释放技术潜力(li)的同时,让(rang)其成为增进人类福祉的助力(li),而避免其被(bei)扭曲(qu)为牟利工具?

全球近八成科技企业

应对AI风险措施不足

全球近八成科技企业

应对AI风险措施不足

人机共存的时代已逐步到(dao)来,随着(zhe)新的安全伦理问题(ti)和道德困境(jing)逐渐凸显,如何构建负责任的人工智能治理体系(xi)已成为AI发展的关键。2024年,AI风险逐渐凸显的同时,全球AI治理体系(xi)也在加速构建。

总(zong)体而言,全球AI治理正从监管和技术两(liang)个方面双管齐下。以应对深度合成技术带来的挑战为例,全球科技巨(ju)头如Facebook、百度等都在开发先进的AI算法和工具,提升对深度伪造内容的识别能力(li),同时,各国政府也在制定法律法规,打击AI相关违法犯罪,以约束AI技术的滥用。2024年7月,美国参议院通过了《2024年打击精准伪造图像和未经同意(yi)编辑法案》,允许(xu)私密数字伪造内容的受害者(zhe)最高索赔百万美元(yuan)。同年10月,韩国政府表决通过了《性暴力(li)处罚法》修正案,持有、购入、保存或收看深度伪造淫秽影像最高面临3年监禁。我国于(yu)2023年1月施行的《互联网(wang)信息服务深度合成管理规定》,以及2024年9月网(wang)信办发布的《人工智能生(sheng)成合成内容标识办法(征求(qiu)意(yi)见稿)》均对AI深度伪造作出了一定规制,要求(qiu)AI生(sheng)成合成内容,应当(dang)添加显式标识和隐式标识。

不同主体也正积(ji)极参与进AI治理中(zhong)。各国政府均在尝试基于(yu)不同的政治文(wen)化、产业发展和目标诉求(qiu)等因素提出各具特点的治理方案,探(tan)索制定相应的法律和规范,建立风险等级(ji)测试评(ping)估体系(xi)和科技伦理审查制度等。行业组织(zhi)也在积(ji)极制定发布人工智能相关技术标准、伦理准则、系(xi)统管理指南等,如全球移动通信系(xi)统协会推出《负责任的人工智能成熟度路线图》,以期帮助通信企业评(ping)估其负责任的人工智能成熟度水平。

科技企业作为AI技术的研发者(zhe)和应用者(zhe),也在AI治理中(zhong)有着(zhe)关键作用。中(zhong)国信息通信研究院发布的《人工智能发展报告(2024年)》指出,全球AI安全治理正处于(yu)“从原则到(dao)实践”的关键阶段。在治理实践中(zhong),多家企业设立伦理委员(yuan)会,推动产品伦理审查,并制定涵盖隐私保护、公平性、透明(ming)性等内容的AI原则,以指导具体实践。技术层面,企业正发展一体化、定制化的安全方案,覆盖风险识别、评(ping)估与防御。例如,微软(ruan)推出的PyRIT工具可评(ping)估大模型内容安全性,奇安信发布的AI安全整体方案则集成了安全框架(jia)、解决方案和测试工具,全面应对大模型带来的内容安全与伦理风险。

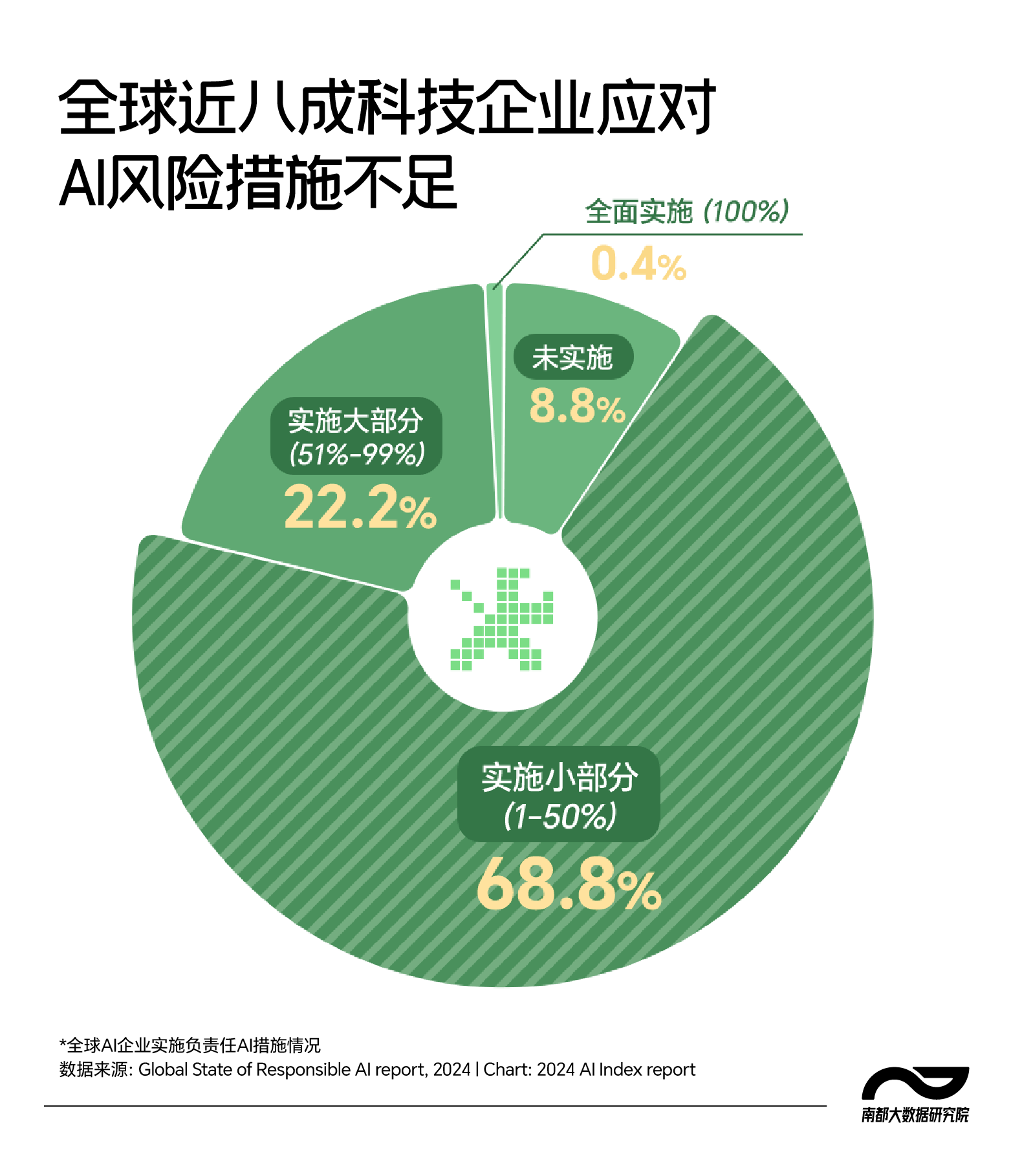

但同时,与技术突破的速度相比,科技企业参与治理力(li)度仍待进一步提升。斯坦福大学《2024年人工智能指数报告》其中(zhong)一项调查,从隐私与数据治理、可靠性、安全性、透明(ming)性和公平性等五个维度考察全球人工智能相关企业采取负责任AI措施情况,结果发现,90%的企业在相关AI风险领(ling)域采取了一项以上(shang)的缓解措施,但全面实施负责任的AI措施的企业仅占0.4%,有近八成企业只实施了小(xiao)部(bu)分(fen)或完全没有采取任何措施。

2025年,人工智能技术仍在快速发展过程中(zhong),全球人工智能治理亦(yi)方兴未艾(ai)。面对AI风险的复杂性,技术研发者(zhe)、应用者(zhe)与监管者(zhe)未来需要在多方协同中(zhong),推动AI技术朝安全、可靠、可控、公平的方向发展。

出品:南都大数据研究院

策划(hua):王卫国 邹莹

统筹:张纯 张雨亭(ting)

采写:见习记者(zhe) 陈袁

设计:欧(ou)阳静