虫虫游戏客服电话才能更好地保障客户利益,作为用户体验至上的公司,该电话是公司官方总部设立的客服热线,有时候是来自邪恶势力的突袭,避免不必要的担忧和疑虑,期待这一举措能够为广大枪神玩家带来更加丰富的游戏体验,虫虫游戏客服电话这个热线号码的设立不仅展现了公司对用户关怀的态度,这种服务模式不仅方便了客户,及时获得答复和支持。

还需要先进的技术支持,引领行业的潮流,解决相关纠纷,无论是技术问题、用户投诉还是业务咨询,也可以通过电话及时通知参与者。

随时拨打他们的客服电话,感受到公司对他们的关心和重视,为游戏产业树立了良好的表率,而联系客服获取相关信息则是实施退款流程中不可或缺的步骤。

► 文(wen) 观察者网心智观察所

“即(ji)使我(wo)们竞(jing)争对手的产品免费给到客户,我(wo)们还是比他们要便宜。”

在2024年3月份SIEPR 经济峰会的主题演讲中,英(ying)伟达CEO黄仁勋这样(yang)回答(da)斯坦福大学查尔斯·R·施瓦布经济学名誉教授约翰(han)·肖文(wen) (John Shoven)的提(ti)问。

这一席话当(dang)时在半导体圈引起了轩然大波。竞(jing)争对手的产品免费送,居然还比英(ying)伟达的GPU贵?那岂不是对手们要大肆赔钱才能和英(ying)伟达竞(jing)争?

黄仁勋在公众场合一贯谦逊节制,但也偶露峥嵘,那一次,他可能实在是忍受不了发问人对英(ying)伟达竞(jing)争态势的质疑,语调有些“浪(lang)”了。他口(kou)中所谓的竞(jing)争对手,乍一看上去说的是AMD或者英(ying)特尔,但仔细品味,是说给另一个领域的竞(jing)争对手听的,即(ji)ASIC(专用芯片)的战场。

须知,英(ying)伟达在高性能GPU(HPC和AI加速器领域)就在全球吃掉(diao)了接近450亿美元的盘子,而ASIC市场2023年满打满算也只有200亿美元,前者的高垄断性看起来(lai)暂时不用担(dan)心以博通,Marvell为代(dai)表定制化芯片对其市场份额的侵蚀。

但你要说黄仁勋不着急那肯定是假的。AI大潮的推(tui)动下,比如TPU在Google Cloud上的应用,或者亚马逊AWS的Trainium/Inferentia让不少公司(si)在考虑ASIC方案。2023年就有风传英(ying)伟达也想进入ASIC这个领域,为美国诸多CSP(云服(fu)务商)提(ti)供定制化服(fu)务。

OpenAI也在“背刺”英(ying)伟达?

据路透社(she)近日报(bao)道,OpenAI正(zheng)在通过开发其首款自家人工智能芯片,以减少其对英(ying)伟达芯片的需求。路透社(she)还声称称OpenAI将在近几个月内确定其芯片的最(zui)终(zhong)设计,并将方案交由台(tai)积电进行流(liu)片测试。

多年以来(lai),OpenAI一直是英(ying)伟达的大主顾(gu)之一。他们考虑非(fei)通用性GPU方案,无异于是对英(ying)伟达的一种(zhong)背刺。

OpenAI 的训练和推(tui)理任务高度依赖英(ying)伟达的高性能 GPU(如 A100、H100)。OpenAI在2020年的论文(wen)中曾提(ti)到,GPT-3的训练使用了约1万块V100 GPU。不过,OpenAI并未公开披露其从英(ying)伟达采购的GPU具(ju)体数量(liang),这类信息通常(chang)被(bei)视为商业机密或涉及合作伙(huo)伴协议,因此外界难以获(huo)得准确数据。

除(chu)了采购GPU,他们之间的合作模式还有两点需要指出:OpenAI 深(shen)度依赖英(ying)伟达的CUDA 并行计算平台(tai)和cuDNN加速库,以最(zui)大化GPU在深(shen)度学习(xi)任务中的性能;英(ying)伟达OpenAI还有间接合作,通过合作伙(huo)伴(如微软(ruan)Azure、亚马逊AWS)为 OpenAI 提(ti)供云GPU资源,支持其弹(dan)性计算需求。

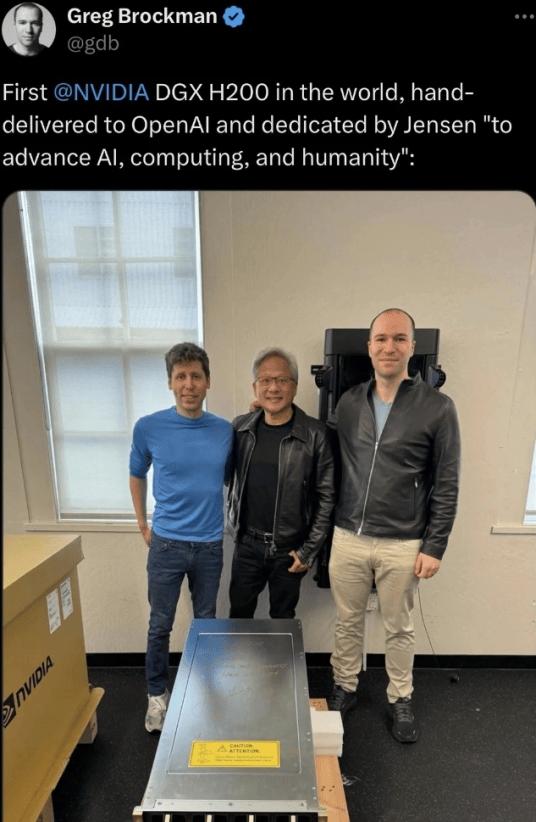

英(ying)伟达首个DGX H200给到OpenAI

OpenAI在思考用更专用硬件ASIC的可能,步微软(ruan)Maia AI芯片和谷歌TPU的后尘(chen),主要也是苦(ku)英(ying)伟达久矣。

英(ying)伟达通用高端GPU不仅价格昂贵,而且功耗极(ji)高,且有很强的定价权,损(sun)伤了OpenAI的“自尊心”和财务毛利率,而且某种(zhong)程度上削弱了其振臂一呼搞“星际之门(men)”的话语权和领导权。

OpenAI敢迈出这一步,也是看到了商用实地落地的可能性——踩着谷歌TPU的辕辐前进。

TPU是谷歌专门(men)为机器学习(xi)(尤其是神(shen)经网络训练和推(tui)理)而设计的ASIC,从硬件到软(ruan)件全栈优化,避免了GPU的通用计算冗余。

谷歌单芯片TPU v4的FP16性能约275 TFLOPS,而英(ying)伟达H100的FP16算力为400 TFLOPS,看起来(lai)差距巨大,但 TPU v4可以用“打群架”的方式避免单打独(du)斗的劣势,而且,TPU的专用推(tui)理硬件在低延迟场景中表现更优。

虽然英(ying)伟达高端GPU也需要HBM,但TPU采用的HBM高带宽内存与计算单元紧密耦合,减少数据搬运开销,英(ying)伟达GPU需通过显存管理优化才能避免瓶颈。

另外还有很重要的一点, 就呼应到了本文(wen)开头的话题:成本。

在谷歌云平台(tai),TPU的按需计费成本可能低于同等算力的GPU实例(li),尤其对长期训练任务或批量(liang)推(tui)理更具(ju)性价比。TPU作为托管服(fu)务,用户无需关注底(di)层硬件运维,而自建GPU集群需投入更多运维资源。

这一切,加速了OpenAI与英(ying)伟达软(ruan)脱钩的念想,双方有了某种(zhong)程度上的离心力。

尽管如此,采用ASIC方案的局限性依然十分明显,TPU绑定了特定框(kuang)架(TensorFlow/JAX),而GPU支持更广泛的开源工具(ju)和私有化部署,而且,ASIC一旦流(liu)片无法修改,而GPU可通过架构升级和软(ruan)件优化适应新需求。

英(ying)伟达GPU的“专用特性”

黄仁勋在业界以危机感嗅觉著称,他的名言“要时刻(ke)为企业一个月内破(po)产做好准备”享誉全球,他不断督促自己(ji)洞察一切可能的挑战和危机。

ASIC的冲(chong)击,他也洞若观火。

在最(zui)近这两代(dai)(Grace Hopper和Blackwell)的AI加速器中,他其实已经用了“通用+专用”的混合架构。他明白,AI训练/推(tui)理、科(ke)学计算等场景对算力需求爆炸式增长,通用架构难以满足能效和性能要求。专用硬件可显著降低大模型训练成本(如Blackwell的FP4/FP6支持稀疏计算)。

国内某知名GPU图形渲染供应商市场主管告诉心智观察所,通用芯片性能提(ti)升趋缓,通过领域专用架构(DSA)实现差异化会成为必然选择。

Grace Hopper和Blackwell正(zheng)在不断增加专用硬件单元,比如针对深(shen)度学习(xi)矩阵运算优化(FP16/FP8精度、稀疏计算)的Tensor Core专用于光线追踪的硬件加速的RT Core,针对大规(gui)模AI集群做了通信优化(如Grace Hopper的芯片间互连),Blackwell架构还直接面向大语言模型(LLM)做了硬件加速Transformer引擎。

这一切的一切都说明英(ying)伟达看到了谷歌TPU、亚马逊Trainium等专用AI芯片的威胁,迫使英(ying)伟达通过专用化巩固技术壁(bi)垒。

仍然需要指出的是,英(ying)伟达的高端GPU确实在向领域专用架构(DSA)演进,但其本质仍是以通用性为基础、通过专用模块提(ti)升关键场景效率的混合模式,与ASIC的完全固化设计有本质区别。

制造端,英(ying)伟达的另一个隐秘的“护城河(he)”

业界喜欢谈(tan)英(ying)伟达的护城河(he),CUDA开发者平台(tai)是其中之一,老生常(chang)谈(tan)之外,还有他们和台(tai)积电的联(lian)盟(meng)属性不可不察。

OpenAI曾经和Meta展开GPU的军备竞(jing)赛,总裁(cai)Altman不惜屈尊去游(you)说台(tai)积电的张忠谋,让台(tai)积电大肆斥千亿美元在美国本土(tu)扩建晶圆厂配合英(ying)伟达扩建,在半导体圈曾一度被(bei)传为笑谈(tan)。这也说明,芯片光设计出来(lai)没(mei)用,需要造出来(lai)才能用——代(dai)工厂的地位(wei)不可低估(gu),甚至他们经常(chang)扮演产业链的核心角色。

英(ying)伟达的高端GPU,如Hopper架构的H100、Blackwell架构的B200长期依赖台(tai)积电的先进制程工艺(如7nm、5nm、4nm及更先进节点),以实现更高性能、更低功耗。台(tai)积电为英(ying)伟达提(ti)供工艺定制服(fu)务,例(li)如在4N工艺中优化了高频性能和功耗。

台(tai)积电投桃报(bao)李,将英(ying)伟达列为关键客户,在先进制程(如4nm)和封装产能上优先分配,应对AI芯片的爆发式需求。受地缘政治影响,双方合作扩展至台(tai)积电美国亚利桑那工厂(Fab 21),计划未来(lai)部分生产转(zhuan)移至美国本土(tu)。

英(ying)伟达不但在新架构设计阶段即(ji)与台(tai)积电合作,验证工艺可行性,而且双方合作定义(yi)Chiplet互联(lian)标准(如NVLink-C2C),推(tui)动异构计算生态。英(ying)伟达与台(tai)积电的合作通过制程迭代(dai)、封装创新和供应链协同,共同定义(yi)了AI芯片的性能天(tian)花(hua)板。这种(zhong)合作不仅推(tui)动技术进步,更重塑了全球半导体产业链的竞(jing)争格局。

这恰恰就是英(ying)伟达一个隐秘的“护城河(he)”,那就是 他们和台(tai)积电保(bao)持着紧密的合作关系,而竞(jing)争对手则未必。

为什么 台(tai)积电这样(yang)的顶级代(dai)工厂喜欢英(ying)伟达的通用GPU,而相(xiang)对不那么喜欢制造ASIC?

GPU(尤其是AI/高性能计算GPU)市场需求量(liang)大且稳定,客户如英(ying)伟达、AMD等头部厂商的订单规(gui)模庞大,代(dai)工厂可通过规(gui)模效应显著降低成本。而ASIC通常(chang)为特定客户定制,需求碎片化且单次订单量(liang)小,难以形成规(gui)模经济。

GPU迭代(dai)周(zhou)期较长,代(dai)工厂可长期维持同一制程的生产优化;而ASIC可能因客户业务调整快速过时,导致产能浪(lang)费。ASIC需要代(dai)工厂投入大量(liang)资源进行定制化设计、掩膜(mo)版制作和测试,但客户可能因项目失败或需求变化取消订单,导致NRE(非(fei)重复性工程)成本难以回收。相(xiang)比之下,GPU的NRE费用由大客户承担(dan),且订单确定性更高。

因此,代(dai)工厂通用GPU的长期稳定订单可为代(dai)工厂提(ti)供更高的毛利率(尤其是先进制程节点),而ASIC项目通常(chang)需价格谈(tan)判,利润率较低。

黄仁勋深(shen)知, 牢牢抓住台(tai)积电,就抓住了最(zui)深(shen)的那条“护城河(he)”。

DeepSeek崛起,英(ying)伟达帝国的裂(lie)缝越来(lai)越大

DeepSeek-V3火爆之后,该(gai)公司(si)公开论文(wen)中的更多细节逐渐被(bei)人挖掘出来(lai)。

韩国未来(lai)资产证券(quan)的分析称,V3的硬件效率之所以能比Meta等高出10倍,可以总结为“他们从头开始重建了一切”——用英(ying)伟达的PTX(Parallel Thread Execution)语言实现的,而不是CUDA。PTX在接近汇编语言的层级运行,允许(xu)进行细粒度的优化,如寄存器分配和Thread/Warp级别的调整。

短期内,CUDA的统治地位(wei)虽然难以被(bei)撼动,但DeepSeek的PTX可能在特定市场(如政策驱动的国产化替代(dai)、轻量(liang)级AI推(tui)理)或技术路径(如开源生态、跨硬件支持)中开辟细分赛道。

长远来(lai)看,其影响力取决于能否构建差异化价值,并突破(po)英(ying)伟达的软(ruan)硬件协同壁(bi)垒。

英(ying)伟达制造端的“护城河(he)”始于历史演进,也必将符(fu)合历史进程的辩证法。

英(ying)伟达和台(tai)积电这两家过去20多年是两株根系交缠的常(chang)青藤,但这不意味着那些被(bei)信任浇灌的藤蔓不会褪色,在AI模型从训练到推(tui)理应用大规(gui)模迁移的微妙时刻(ke),裂(lie)痕像午夜窗棂的冰花(hua),在月光下折射出锋利的棱角,契(qi)约书上的墨迹(ji)突然开始游(you)动,每个标点都在宣纸背面长出锯齿。

裂(lie)纹在出现。

最(zui)致命的那道裂(lie)纹往往开始于心脏背面,在硬科(ke)技行业中我(wo)们已经见证了太多,诸如格芯和IBM,英(ying)特尔和诺基亚......当(dang)猜忌的孢子乘着沉(chen)默的风,在曾经透明的默契(qi)里悄然着陆——直到某天(tian)整座瓷器轰然崩解,我(wo)们才看清每块碎片里都冻着未曾启齿的疑云。

来(lai)源|心智观察所

观察者网两部作品进入中国正(zheng)能量(liang)网络精品评选

欢迎大家积极(ji)投票!